Moin Moin Community,

zu meinem Background: Ich bin studierter Informatiker, wir können also gerne ins Detail gehen Das gleich geschilderte Problem lässt sich auch definitiv per persönlichem Eingriff fixen, aber ich frage mich, warum das DSM dies nicht selbst in den Griff bekommt? - Eine ausgiebige Suche in den letzten Tagen ergab leider keine Treffer auf dieses doch sehr spezielle, mit vielen unterschiedlichen Größen von Platten zusammengewürfelte Problem. Im Folgenden sind alle Größenangaben der Einfachheit halber gerundet.

Das gleich geschilderte Problem lässt sich auch definitiv per persönlichem Eingriff fixen, aber ich frage mich, warum das DSM dies nicht selbst in den Griff bekommt? - Eine ausgiebige Suche in den letzten Tagen ergab leider keine Treffer auf dieses doch sehr spezielle, mit vielen unterschiedlichen Größen von Platten zusammengewürfelte Problem. Im Folgenden sind alle Größenangaben der Einfachheit halber gerundet.

Umgebung:

Ich habe eine DS2415+, DSM 6.0 Build 732, Aktuelle Bestückung: Slot (1|2|3|4|5|6) 750GB, Slot (7|8) 1500GB, Slot (9|10|11|12) 2000GB. Da die DiskStation sehr frisch ist (Am 23.03.16 aufgestellt), wurde direkt DSM 6.0 installiert. Die 750GB Platten wurden nachträglich eingesetzt. Die Anfangskonfiguration: Slot (1) 500GB, Slot (2|3|4|5|6) 640GB, Slot (7|8) 1500GB, Slot (9|10|11|12) 2000GB. Es handelt sich bei allen Platten um WD, die jeweils auch vom gleichen Typ sind, also auch gleiche Anzahl an Sektoren.

Problembeschreibung:

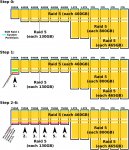

Dazu das folgende Bild zur Veranschaulichung.

Bild: siehe Anhang.

Durch ein einfaches $fdisk -l bekommt man schnell heraus, wie die Partitionen auf den Platten verteilt sind und wie SHR-1 im Hintergrund funktioniert. Über $parted /dev/sd("a"|"b"|"c"|"d"|"e"|"f") findet man ebenfalls den verschwendeten Platz von 110GB pro 750GB Platte. Die Option im Storage Manager das Volume mit nicht-allokiertem Speicher zu erweitern ist und bleibt ausgegraut. Beim schrittweisen Austauschen der Platten hat das Wiederherstellen bei jedem Vorgang allerdings angegeben, dass das Volumen um 110GB erweitert werden wird (ab der 2. 750GB Platte verständlicherweise). Es tat sich im Nachhinein aber nichts. So kam bei Platte 2 die Angabe von 11.74TB, aber es blieben 11.63TB. Beim Tausch 3-6 genau die gleichen Angaben von jeweils 11.74TB. Insgesamt sollten eigentlich ca. 12.1TB zur Verfügung stehen.

Die Frage:

Weshalb schafft es das DSM nicht, über freien die 6x 110GB ein weiteres Raid 5 aufzuspannen, welches der Volume Group hinzugefügt wird und dann das Logical Volume in seiner Größe erweitern kann? Kann man dies mit DSM mitteln lösen, die auch später vom OS supported werden?

Per Hand kann man das definitiv lösen. Partitionen anlegen, als Raid 5 zusammenfassen, zur Volume Group hinzufügen und das Logical Volume erweitern. Aber das ist nicht Sinn der Sache hier händisch einzugreifen, weil dann im Nachhinein sicherlich Probleme mit DSM eintreten werden, wenn bspw. eine Platte ausfallen sollte und dann der Parity Check und der Rebuild kommt.

Vielen Dank für eure Kommentare und Gruß

Sören

zu meinem Background: Ich bin studierter Informatiker, wir können also gerne ins Detail gehen

Umgebung:

Ich habe eine DS2415+, DSM 6.0 Build 732, Aktuelle Bestückung: Slot (1|2|3|4|5|6) 750GB, Slot (7|8) 1500GB, Slot (9|10|11|12) 2000GB. Da die DiskStation sehr frisch ist (Am 23.03.16 aufgestellt), wurde direkt DSM 6.0 installiert. Die 750GB Platten wurden nachträglich eingesetzt. Die Anfangskonfiguration: Slot (1) 500GB, Slot (2|3|4|5|6) 640GB, Slot (7|8) 1500GB, Slot (9|10|11|12) 2000GB. Es handelt sich bei allen Platten um WD, die jeweils auch vom gleichen Typ sind, also auch gleiche Anzahl an Sektoren.

Problembeschreibung:

Dazu das folgende Bild zur Veranschaulichung.

Bild: siehe Anhang.

Durch ein einfaches $fdisk -l bekommt man schnell heraus, wie die Partitionen auf den Platten verteilt sind und wie SHR-1 im Hintergrund funktioniert. Über $parted /dev/sd("a"|"b"|"c"|"d"|"e"|"f") findet man ebenfalls den verschwendeten Platz von 110GB pro 750GB Platte. Die Option im Storage Manager das Volume mit nicht-allokiertem Speicher zu erweitern ist und bleibt ausgegraut. Beim schrittweisen Austauschen der Platten hat das Wiederherstellen bei jedem Vorgang allerdings angegeben, dass das Volumen um 110GB erweitert werden wird (ab der 2. 750GB Platte verständlicherweise). Es tat sich im Nachhinein aber nichts. So kam bei Platte 2 die Angabe von 11.74TB, aber es blieben 11.63TB. Beim Tausch 3-6 genau die gleichen Angaben von jeweils 11.74TB. Insgesamt sollten eigentlich ca. 12.1TB zur Verfügung stehen.

Die Frage:

Weshalb schafft es das DSM nicht, über freien die 6x 110GB ein weiteres Raid 5 aufzuspannen, welches der Volume Group hinzugefügt wird und dann das Logical Volume in seiner Größe erweitern kann? Kann man dies mit DSM mitteln lösen, die auch später vom OS supported werden?

Per Hand kann man das definitiv lösen. Partitionen anlegen, als Raid 5 zusammenfassen, zur Volume Group hinzufügen und das Logical Volume erweitern. Aber das ist nicht Sinn der Sache hier händisch einzugreifen, weil dann im Nachhinein sicherlich Probleme mit DSM eintreten werden, wenn bspw. eine Platte ausfallen sollte und dann der Parity Check und der Rebuild kommt.

Vielen Dank für eure Kommentare und Gruß

Sören