- Mitglied seit

- 08. Nov 2022

- Beiträge

- 16

- Punkte für Reaktionen

- 3

- Punkte

- 3

Hallo geehrte Forums-Community,

dies ist mein erster Forenpost hier, bitte um Gnade.

Ausgangssituation: Wir besitzen ein DS218+ mit 10 GB RAM und zwei 8TB WD Red das mit einem SHR (gespiegelt RAID1) konfiguriert ist. SMART Werte der HDDs sagen, dass diese im Schnellcheck ok sind. DSM ist ein 7.1.x

Letzte Woche ist es beim kopieren von Backups auf das NAS per NFS Protokoll zum Crash des BTRFS Filesystems gekommen und nun ist dieses nur noch READ-ONLY verfügbar, was natürlich nicht wirklich hilfreich ist im täglichen Betrieb. (Die Daten habe ich soweit es geht via SSH auf eine ext. angeschlossene 8TB USB Festplatte gesichert, bevor ich Reparaturversuche gestartet habe.)

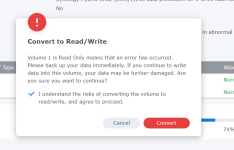

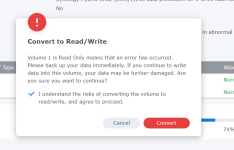

Mittlerweile habe ich im DSM das Filesystem wieder schreibend eingebunden und versucht einen Data Scrubbing Job laufen zu lassen, um das Problem zu beheben. Dieser Job bricht leider wieder mit dem BTRFS Critical fehler ab und versetzt das Filesystem wieder in den Read Only Mode.

Im Netz habe ich noch den Befehl btrfs check --repair gefunden, habe mich aber noch nicht dazu durchgerungen diesen auszuführen, da

Ich habe auch schon ein Support Ticket bei Synology eröffnet und versucht dieses per Hotline zu eskalieren, leider habe ich nach über einer Woche immer noch kein Feedback erhalten, was sehr frustrierend ist.

Die Google-Suche war leider auch nicht sehr aufschlussreich für mich.

Vielen Dank im Voraus für eure Hilfe!

Anbei folgt der Auszug des Errors aus der DMESG des Synology Betriebssystems:

_________________________________________________________________________________________________________

dies ist mein erster Forenpost hier, bitte um Gnade.

Ausgangssituation: Wir besitzen ein DS218+ mit 10 GB RAM und zwei 8TB WD Red das mit einem SHR (gespiegelt RAID1) konfiguriert ist. SMART Werte der HDDs sagen, dass diese im Schnellcheck ok sind. DSM ist ein 7.1.x

Letzte Woche ist es beim kopieren von Backups auf das NAS per NFS Protokoll zum Crash des BTRFS Filesystems gekommen und nun ist dieses nur noch READ-ONLY verfügbar, was natürlich nicht wirklich hilfreich ist im täglichen Betrieb. (Die Daten habe ich soweit es geht via SSH auf eine ext. angeschlossene 8TB USB Festplatte gesichert, bevor ich Reparaturversuche gestartet habe.)

Mittlerweile habe ich im DSM das Filesystem wieder schreibend eingebunden und versucht einen Data Scrubbing Job laufen zu lassen, um das Problem zu beheben. Dieser Job bricht leider wieder mit dem BTRFS Critical fehler ab und versetzt das Filesystem wieder in den Read Only Mode.

Im Netz habe ich noch den Befehl btrfs check --repair gefunden, habe mich aber noch nicht dazu durchgerungen diesen auszuführen, da

The very last resort tool is btrfs check --repair. It's reported to fix some issues some of the time, but with a good chance it will make others worse! You have been warned! Please see the btrfs check --repair wiki page.

Ich habe auch schon ein Support Ticket bei Synology eröffnet und versucht dieses per Hotline zu eskalieren, leider habe ich nach über einer Woche immer noch kein Feedback erhalten, was sehr frustrierend ist.

Die Google-Suche war leider auch nicht sehr aufschlussreich für mich.

- Was kann ich machen um das Filesystem zu reparieren, oder wie finde ich heraus welche Dateien nun corrupt sind im File System Tree? Eventuell kann man diesen leaf in dem Filesystem löschen und mit dem Filesystem weiter arbeiten?

- Hat hierzu schon einmal jemand Erfahrungen gesammelt und möchte diese an mich weitergeben?

- Könnte jemand das DMESG interpretieren und mir versuchen zu erklären, was schief gegangen ist?

- Kennt jemand einen Synology Partner der uns mit der Behebung dieses Problems professionell und gegen Bezahlung helfen könnte?

Vielen Dank im Voraus für eure Hilfe!

Anbei folgt der Auszug des Errors aus der DMESG des Synology Betriebssystems:

_________________________________________________________________________________________________________

Code:

[Fri Oct 28 22:13:44 2022] BTRFS critical (device dm-0): corrupt leaf: block=3827529744384 slot=238 extent bytenr=2866198822912 len=16384 invalid tree level, have 1717969184 expect [0, 7]

[Fri Oct 28 22:13:44 2022] md2: [Self Heal] Retry sector [2682620672] round [1/2] start: choose disk [0:sda5]

[Fri Oct 28 22:13:44 2022] md2: [Self Heal] Retry sector [2682620680] round [1/2] start: choose disk [0:sda5]

[Fri Oct 28 22:13:44 2022] md2: [Self Heal] Retry sector [2682620688] round [1/2] start: choose disk [0:sda5]

[Fri Oct 28 22:13:44 2022] md2: [Self Heal] Retry sector [2682620672] round [1/2] finished: return result to upper layer

[Fri Oct 28 22:13:44 2022] md2: [Self Heal] Retry sector [2682620680] round [1/2] finished: return result to upper layer

[Fri Oct 28 22:13:44 2022] md2: [Self Heal] Retry sector [2682620696] round [1/2] start: choose disk [0:sda5]

[Fri Oct 28 22:13:44 2022] md2: [Self Heal] Retry sector [2682620688] round [1/2] finished: return result to upper layer

[Fri Oct 28 22:13:44 2022] md2: [Self Heal] Retry sector [2682620696] round [1/2] finished: return result to upper layer

[Fri Oct 28 22:13:44 2022] BTRFS critical (device dm-0): corrupt leaf: block=3827529744384 slot=238 extent bytenr=2866198822912 len=16384 invalid tree level, have 1717969184 expect [0, 7]

[Fri Oct 28 22:13:44 2022] md2: [Self Heal] Retry sector [2682620672] round [1/2] start: choose disk [0:sda5]

[Fri Oct 28 22:13:44 2022] md2: [Self Heal] Retry sector [2682620680] round [1/2] start: choose disk [0:sda5]

[Fri Oct 28 22:13:44 2022] md2: [Self Heal] Retry sector [2682620672] round [1/2] finished: get same result, retry next round

[Fri Oct 28 22:13:44 2022] md2: [Self Heal] Retry sector [2682620672] round [2/2] start: choose disk [1:sdb5]

[Fri Oct 28 22:13:44 2022] md2: [Self Heal] Retry sector [2682620672] round [2/2] finished: get same result, retry next round

[Fri Oct 28 22:13:44 2022] md2: [Self Heal] Retry sector [2682620672] round [5/2] error: cannot find a suitable device, bio sector length [8], request_cnt [2]

[Fri Oct 28 22:13:44 2022] md2: [Self Heal] Retry sector [2682620688] round [1/2] start: choose disk [0:sda5]

[Fri Oct 28 22:13:44 2022] md2: [Self Heal] Retry sector [2682620696] round [1/2] start: choose disk [0:sda5]

[Fri Oct 28 22:13:44 2022] md2: [Self Heal] Retry sector [2682620680] round [1/2] finished: get same result, retry next round

[Fri Oct 28 22:13:44 2022] md2: [Self Heal] Retry sector [2682620688] round [1/2] finished: get same result, retry next round

[Fri Oct 28 22:13:44 2022] md2: [Self Heal] Retry sector [2682620688] round [2/2] start: choose disk [1:sdb5]

[Fri Oct 28 22:13:44 2022] md2: [Self Heal] Retry sector [2682620680] round [2/2] start: choose disk [1:sdb5]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2682620680] round [2/2] finished: get same result, retry next round

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2682620688] round [2/2] finished: get same result, retry next round

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2682620688] round [5/2] error: cannot find a suitable device, bio sector length [8], request_cnt [2]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2682620680] round [5/2] error: cannot find a suitable device, bio sector length [8], request_cnt [2]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2682620696] round [1/2] finished: get same result, retry next round

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2682620696] round [2/2] start: choose disk [1:sdb5]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2682620696] round [2/2] finished: get same result, retry next round

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2682620696] round [5/2] error: cannot find a suitable device, bio sector length [8], request_cnt [2]

[Fri Oct 28 22:13:45 2022] BTRFS critical (device dm-0): corrupt leaf: block=3827529744384 slot=238 extent bytenr=2866198822912 len=16384 invalid tree level, have 1717969184 expect [0, 7]

[Fri Oct 28 22:13:45 2022] ------------[ cut here ]------------

[Fri Oct 28 22:13:45 2022] WARNING: CPU: 0 PID: 27132 at fs/btrfs/disk-io.c:916 btree_io_failed_hook+0x12d/0x220 [btrfs]()

[Fri Oct 28 22:13:45 2022] Modules linked in: xt_ipvs ip_vs_rr ip_vs xt_mark iptable_mangle br_netfilter bridge stp aufs macvlan veth xt_conntrack nf_conntrack_ipv6 ip6able_filter ip6_tables xt_REDIRECT xt_nat nf_nat_redirect xt_recent xt_iprange xt_limit xt_state xt_tcpudp xt_multiport xt_LOG xt_TCPMSS pci_stub vfio_pci vfio_virqfd vio_iommu_type1 vfio vhost_net(O) tun kvm_intel kvm irqbypass vfat fat nfnetlink xfrm_user xfrm_algo xt_addrtype ipt_MASQUERADE nf_nat_masquerade_ipv4 iptable_nat nf_natipv4 nf_nat nf_conntrack_ipv4 nf_defrag_ipv4 iptable_filter ip_tables fuse 8021q vhost_scsi(O) vhost(O) tcm_loop(O) iscsi_target_mod(O) target_core_user(O) target_core_p(O) target_core_multi_file(O) target_core_file(O) target_core_iblock(O) target_core_mod(O) syno_extent_pool(PO) rodsp_ep(O) udf isofs loop x_tables

[Fri Oct 28 22:13:45 2022] nfsv4 nfs synoacl_vfs(PO) nfsd btrfs ecryptfs zstd_decompress zstd_compress xxhash xor raid6_pq lockd grace rpcsec_gss_krb5 auth_rpcgss sunrc openvswitch leds_lp3943 aesni_intel gre glue_helper lrw gf128mul ablk_helper nf_defrag_ipv6 syno_hddmon(P) nf_conntrack apollolake_synobios(PO) hid_generic usbhid hidusblp i915 drm_kms_helper syscopyarea sysfillrect sysimgblt fb_sys_fops cfbfillrect cfbcopyarea cfbimgblt drm drm_panel_orientation_quirks iosf_mbi fb fbdev video backlght button uhci_hcd ehci_pci ehci_hcd usb_storage r8168(O) i2c_algo_bit igb(O) e1000e(O) sg dm_snapshot dm_bufio crc_itu_t crc_ccitt psnap p8022 llc hfsplus md4 hmac si tunnel4 ipv6 flashcache_syno(O) flashcache(O) syno_flashcache_control(O) dm_mod arc4 crc32c_intel cryptd ecb aes_x86_64 authenc des_generic ansi_cprng

[Fri Oct 28 22:13:45 2022] cts md5 cbc cpufreq_powersave cpufreq_performance acpi_cpufreq processor cpufreq_stats vxlan ip6_udp_tunnel udp_tunnel ip_tunnel zram sha256generic synorbd(O) synofsbd(O) etxhci_hcd xhci_pci xhci_hcd usbcore usb_common [last unloaded: xt_LOG]

[Fri Oct 28 22:13:45 2022] CPU: 0 PID: 27132 Comm: kworker/u8:3 Tainted: P O 4.4.180+ #42661

[Fri Oct 28 22:13:45 2022] Hardware name: Synology DS218+/DS218+, BIOS M.135 11/11/2019

[Fri Oct 28 22:13:45 2022] Workqueue: btrfs-endio-meta btrfs_endio_meta_helper [btrfs]

[Fri Oct 28 22:13:45 2022] 0000000000000000 ffff8802d45d7c20 ffffffff812f293d 0000000000000009

[Fri Oct 28 22:13:45 2022] 0000000000000000 ffff8802d45d7c58 ffffffff81051683 ffff88017596d1a0

[Fri Oct 28 22:13:45 2022] ffff880156cad000 ffff8802bdd80240 0000000000000000 0000037b2a8d3000

[Fri Oct 28 22:13:45 2022] Call Trace:

[Fri Oct 28 22:13:45 2022] [<ffffffff812f293d>] dump_stack+0x4d/0x70

[Fri Oct 28 22:13:45 2022] [<ffffffff81051683>] warn_slowpath_common+0x83/0xa0

[Fri Oct 28 22:13:45 2022] [<ffffffff81051756>] warn_slowpath_null+0x16/0x20

[Fri Oct 28 22:13:45 2022] [<ffffffffa078a55d>] btree_io_failed_hook+0x12d/0x220 [btrfs]

[Fri Oct 28 22:13:45 2022] [<ffffffffa07be499>] end_bio_extent_readpage+0x189/0x980 [btrfs]

[Fri Oct 28 22:13:45 2022] [<ffffffff811798db>] ? __slab_free+0x5b/0x220

[Fri Oct 28 22:13:45 2022] [<ffffffff812c7dae>] bio_endio+0xae/0x120

[Fri Oct 28 22:13:45 2022] [<ffffffffa0789057>] end_workqueue_fn+0x27/0x40 [btrfs]

[Fri Oct 28 22:13:45 2022] [<ffffffffa07ceb01>] btrfs_worker_helper+0xd1/0x3a0 [btrfs]

[Fri Oct 28 22:13:45 2022] [<ffffffff810836cc>] ? dequeue_task_fair+0x5bc/0x1160

[Fri Oct 28 22:13:45 2022] [<ffffffffa07cee39>] btrfs_endio_meta_helper+0x9/0x10 [btrfs]

[Fri Oct 28 22:13:45 2022] [<ffffffff810724bb>] worker_run_work+0x9b/0xe0

[Fri Oct 28 22:13:45 2022] [<ffffffffa07cee30>] ? btrfs_endio_helper+0x10/0x10 [btrfs]

[Fri Oct 28 22:13:45 2022] [<ffffffff8106a103>] process_one_work+0x1e3/0x4f0

[Fri Oct 28 22:13:45 2022] [<ffffffff8106a43e>] worker_thread+0x2e/0x4b0

[Fri Oct 28 22:13:45 2022] [<ffffffff8106a410>] ? process_one_work+0x4f0/0x4f0

[Fri Oct 28 22:13:45 2022] [<ffffffff8106e9f5>] kthread+0xd5/0xf0

[Fri Oct 28 22:13:45 2022] [<ffffffff8106e920>] ? kthread_worker_fn+0x160/0x160

[Fri Oct 28 22:13:45 2022] [<ffffffff8157ba2f>] ret_from_fork+0x3f/0x80

[Fri Oct 28 22:13:45 2022] [<ffffffff8106e920>] ? kthread_worker_fn+0x160/0x160

[Fri Oct 28 22:13:45 2022] ---[ end trace 13b2779679250345 ]---

[Fri Oct 28 22:13:45 2022] BTRFS critical (device dm-0): corrupt leaf: block=3827529744384 slot=238 extent bytenr=2866198822912 len=16384 invalid tree level, have 1717969184 expect [0, 7]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669248] round [1/2] start: choose disk [0:sda5]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669256] round [1/2] start: choose disk [0:sda5]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669248] round [1/2] finished: return result to upper layer

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669264] round [1/2] start: choose disk [0:sda5]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669272] round [1/2] start: choose disk [0:sda5]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669256] round [1/2] finished: return result to upper layer

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669264] round [1/2] finished: return result to upper layer

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669272] round [1/2] finished: return result to upper layer

[Fri Oct 28 22:13:45 2022] BTRFS critical (device dm-0): corrupt leaf: block=3827529744384 slot=238 extent bytenr=2866198822912 len=16384 invalid tree level, have 1717969184 expect [0, 7]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669248] round [1/2] start: choose disk [0:sda5]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669256] round [1/2] start: choose disk [0:sda5]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669248] round [1/2] finished: get same result, retry next round

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669248] round [2/2] start: choose disk [1:sdb5]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669248] round [2/2] finished: get same result, retry next round

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669248] round [5/2] error: cannot find a suitable device, bio sector length [8], request_cnt [2]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669264] round [1/2] start: choose disk [0:sda5]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669256] round [1/2] finished: get same result, retry next round

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669256] round [2/2] start: choose disk [1:sdb5]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669256] round [2/2] finished: get same result, retry next round

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669256] round [5/2] error: cannot find a suitable device, bio sector length [8], request_cnt [2]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669272] round [1/2] start: choose disk [0:sda5]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669264] round [1/2] finished: get same result, retry next round

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669264] round [2/2] start: choose disk [1:sdb5]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669264] round [2/2] finished: get same result, retry next round

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669264] round [5/2] error: cannot find a suitable device, bio sector length [8], request_cnt [2]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669272] round [1/2] finished: get same result, retry next round

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669272] round [2/2] start: choose disk [1:sdb5]

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669272] round [2/2] finished: get same result, retry next round

[Fri Oct 28 22:13:45 2022] md2: [Self Heal] Retry sector [2683669272] round [5/2] error: cannot find a suitable device, bio sector length [8], request_cnt [2]

[Fri Oct 28 22:13:45 2022] BTRFS critical (device dm-0): corrupt leaf: block=3827529744384 slot=238 extent bytenr=2866198822912 len=16384 invalid tree level, have 1717969184 expect [0, 7]

[Fri Oct 28 22:13:45 2022] BTRFS error (device dm-0): cannot fix 3827529744384, record in meta_err

[Fri Oct 28 22:13:45 2022] ------------[ cut here ]------------

[Fri Oct 28 22:13:45 2022] WARNING: CPU: 0 PID: 31579 at fs/btrfs/extent-tree.c:7854 __btrfs_free_extent+0x5f2/0xee0 [btrfs]()

[Fri Oct 28 22:13:45 2022] BTRFS: Transaction aborted (error -5)

[Fri Oct 28 22:13:45 2022] Modules linked in: xt_ipvs ip_vs_rr ip_vs xt_mark iptable_mangle br_netfilter bridge stp aufs macvlan veth xt_conntrack nf_conntrack_ipv6 ip6able_filter ip6_tables xt_REDIRECT xt_nat nf_nat_redirect xt_recent xt_iprange xt_limit xt_state xt_tcpudp xt_multiport xt_LOG xt_TCPMSS pci_stub vfio_pci vfio_virqfd vio_iommu_type1 vfio vhost_net(O) tun kvm_intel kvm irqbypass vfat fat nfnetlink xfrm_user xfrm_algo xt_addrtype ipt_MASQUERADE nf_nat_masquerade_ipv4 iptable_nat nf_natipv4 nf_nat nf_conntrack_ipv4 nf_defrag_ipv4 iptable_filter ip_tables fuse 8021q vhost_scsi(O) vhost(O) tcm_loop(O) iscsi_target_mod(O) target_core_user(O) target_core_p(O) target_core_multi_file(O) target_core_file(O) target_core_iblock(O) target_core_mod(O) syno_extent_pool(PO) rodsp_ep(O) udf isofs loop x_tables

[Fri Oct 28 22:13:46 2022] nfsv4 nfs synoacl_vfs(PO) nfsd btrfs ecryptfs zstd_decompress zstd_compress xxhash xor raid6_pq lockd grace rpcsec_gss_krb5 auth_rpcgss sunrc openvswitch leds_lp3943 aesni_intel gre glue_helper lrw gf128mul ablk_helper nf_defrag_ipv6 syno_hddmon(P) nf_conntrack apollolake_synobios(PO) hid_generic usbhid hidusblp i915 drm_kms_helper syscopyarea sysfillrect sysimgblt fb_sys_fops cfbfillrect cfbcopyarea cfbimgblt drm drm_panel_orientation_quirks iosf_mbi fb fbdev video backlght button uhci_hcd ehci_pci ehci_hcd usb_storage r8168(O) i2c_algo_bit igb(O) e1000e(O) sg dm_snapshot dm_bufio crc_itu_t crc_ccitt psnap p8022 llc hfsplus md4 hmac si tunnel4 ipv6 flashcache_syno(O) flashcache(O) syno_flashcache_control(O) dm_mod arc4 crc32c_intel cryptd ecb aes_x86_64 authenc des_generic ansi_cprng

[Fri Oct 28 22:13:46 2022] cts md5 cbc cpufreq_powersave cpufreq_performance acpi_cpufreq processor cpufreq_stats vxlan ip6_udp_tunnel udp_tunnel ip_tunnel zram sha256generic synorbd(O) synofsbd(O) etxhci_hcd xhci_pci xhci_hcd usbcore usb_common [last unloaded: xt_LOG]

[Fri Oct 28 22:13:46 2022] CPU: 0 PID: 31579 Comm: kworker/u8:4 Tainted: P W O 4.4.180+ #42661

[Fri Oct 28 22:13:46 2022] Hardware name: Synology DS218+/DS218+, BIOS M.135 11/11/2019

[Fri Oct 28 22:13:46 2022] Workqueue: btrfs-extent-refs btrfs_extent_refs_helper [btrfs]

[Fri Oct 28 22:13:46 2022] 0000000000000000 ffff8801001a3a30 ffffffff812f293d 0000000000000009

[Fri Oct 28 22:13:46 2022] ffff8801001a3a78 ffff8801001a3a68 ffffffff81051683 0000029b56a40000

[Fri Oct 28 22:13:46 2022] ffff8802b70dc540 ffff880076dfdaf0 00000000fffffffb 0000000000000000

[Fri Oct 28 22:13:46 2022] Call Trace:

[Fri Oct 28 22:13:46 2022] [<ffffffff812f293d>] dump_stack+0x4d/0x70

[Fri Oct 28 22:13:46 2022] [<ffffffff81051683>] warn_slowpath_common+0x83/0xa0

[Fri Oct 28 22:13:46 2022] [<ffffffff810516e9>] warn_slowpath_fmt+0x49/0x50

[Fri Oct 28 22:13:46 2022] [<ffffffffa0773a42>] __btrfs_free_extent+0x5f2/0xee0 [btrfs]

[Fri Oct 28 22:13:46 2022] [<ffffffffa07f38c7>] ? btrfs_merge_delayed_refs+0x67/0x970 [btrfs]

[Fri Oct 28 22:13:46 2022] [<ffffffffa0776d20>] __btrfs_run_delayed_refs+0xaf0/0x1940 [btrfs]

[Fri Oct 28 22:13:46 2022] [<ffffffffa077b421>] btrfs_run_delayed_refs+0xc1/0x4c0 [btrfs]

[Fri Oct 28 22:13:46 2022] [<ffffffffa0795c67>] ? start_transaction+0x97/0x470 [btrfs]

[Fri Oct 28 22:13:46 2022] [<ffffffffa077b862>] delayed_ref_async_start+0x42/0x70 [btrfs]

[Fri Oct 28 22:13:46 2022] [<ffffffffa07ceb01>] btrfs_worker_helper+0xd1/0x3a0 [btrfs]

[Fri Oct 28 22:13:46 2022] [<ffffffff8107e747>] ? sched_clock_cpu+0xa7/0xc0

[Fri Oct 28 22:13:46 2022] [<ffffffffa07cef19>] btrfs_extent_refs_helper+0x9/0x10 [btrfs]

[Fri Oct 28 22:13:46 2022] [<ffffffff810724bb>] worker_run_work+0x9b/0xe0

[Fri Oct 28 22:13:46 2022] [<ffffffffa07cef10>] ? btrfs_usrquota_rescan_helper+0x10/0x10 [btrfs]

[Fri Oct 28 22:13:46 2022] [<ffffffff8106a103>] process_one_work+0x1e3/0x4f0

[Fri Oct 28 22:13:46 2022] [<ffffffff8106a43e>] worker_thread+0x2e/0x4b0

[Fri Oct 28 22:13:46 2022] [<ffffffff8106a410>] ? process_one_work+0x4f0/0x4f0

[Fri Oct 28 22:13:46 2022] [<ffffffff8106e9f5>] kthread+0xd5/0xf0

[Fri Oct 28 22:13:46 2022] [<ffffffff8106e920>] ? kthread_worker_fn+0x160/0x160

[Fri Oct 28 22:13:46 2022] [<ffffffff8157ba2f>] ret_from_fork+0x3f/0x80

[Fri Oct 28 22:13:46 2022] [<ffffffff8106e920>] ? kthread_worker_fn+0x160/0x160

[Fri Oct 28 22:13:46 2022] ---[ end trace 13b2779679250346 ]---

[Fri Oct 28 22:13:46 2022] BTRFS: error (device dm-0) in __btrfs_free_extent:7854: errno=-5 IO failure

[Fri Oct 28 22:13:46 2022] BTRFS info (device dm-0): forced readonly

[Fri Oct 28 22:13:46 2022] BTRFS: error (device dm-0) in btrfs_run_delayed_refs:3379: errno=-5 IO failure

Zuletzt bearbeitet: