- Mitglied seit

- 05. Dez 2009

- Beiträge

- 33

- Punkte für Reaktionen

- 0

- Punkte

- 6

Hi Leute,

ich habe mir jetzt auch eine DS210+ gegönnt, allerdings habe ich massive Probleme mit den Durchsatzraten insbesondere beim Schreiben. Hab bereits alles mögliche was ich hier im Forum gefunden habe ausprobiert und weiss so langsam nicht mehr weiter, hoffe daher dass hier jemand einen Tip hat.

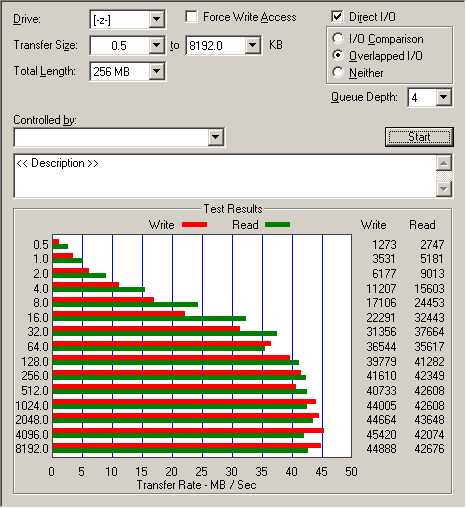

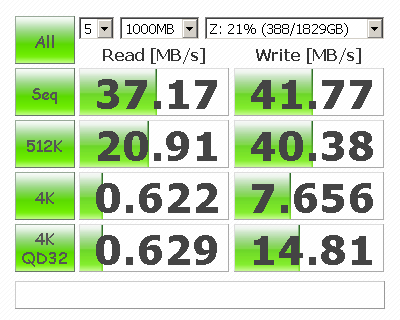

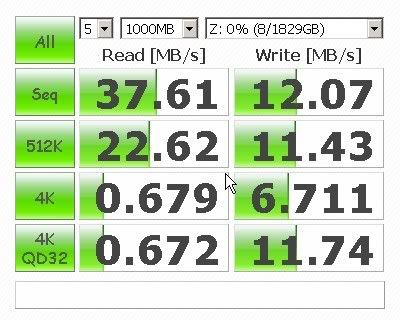

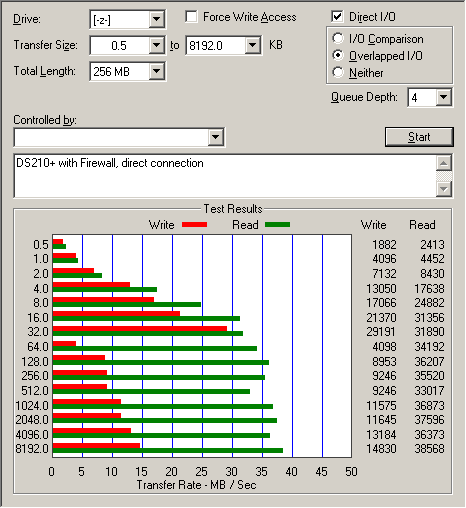

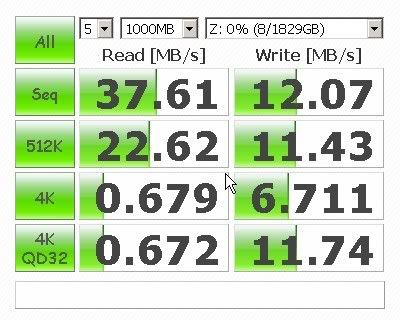

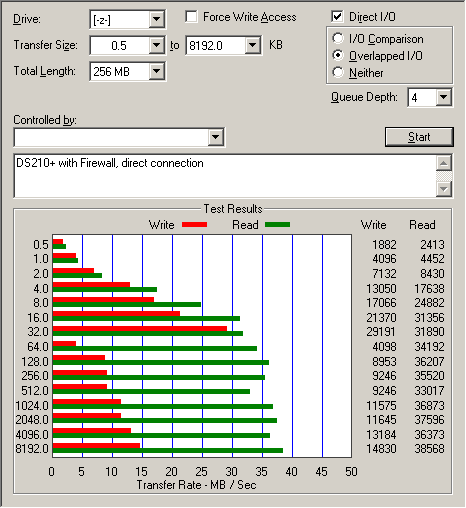

Das Problem sieht man am besten an den folgenden Benchmark-Ergebnissen. Write-Performance mit ca. 12MB/s ist übel, insbesondere verstehe ich nicht warum beim ATTO-Benchmark die Write-Performance ab 64kB Blockgröße drastisch einbricht.

Read-Performance von 37MB/s ist auch deutlich unter den Benchmarks diverser Reviews und von Synology.

Quick Facts zur Hardware:

- PC ASUS P4P800 Board mit GB-LAN (3C940 Chip), Intel P4 2.6GHz, WinXP

- TP-Link TL-SG1005G GB-Switch, CAT5 Kabel

- DS210+ mit DSM 3.0-1340

- 2x Samsung HD204UI (ohne /Z4!, also 512b Blöcke) als RAID1

- Systempartition ext3, Volume1 ext4 Filesystem (so automatisch bei Erstinstallation angelegt, warum?)

Information von "parted":

Information von "fdisk -l -u":

Was ich bisher ausprobiert/überprüft habe:

1) Firewall abgechaltet -> kein Effekt

2) DS210+ direkt am PC ohne Switch -> kein Effekt

3) MTU/Max.FrameSize von 1514 auf Jumboframes 4000 erhöht (PC+NAS) -> kein Effekt

4) FTP statt SMB: Write 15MB/s, Read 18MB/s bei einer 720MB Datei

5) HTTP statt SMB: Write 20MB/s, Read 12MB/s bei einer 720MB Datei

6) laut obigen Infos sollten die Partitionen auf 4k Blockgrenzen liegen, somit ok.

7) auf der DS: 720MB Dateien mit cp kopiert: Durchschnitt Read+Write = 1440MB/28s = 51MB/s

8) auf der DS: 6x720MB Dateien mit tar zusammengefasst: Durchschnitt Read+Write = 8640MB/190s = 45MB/s

9) Resource-Monitor gecheckt: keine Jobs die CPU wegfressen, DS ist idle wenn keine Fileoperationen laufen

Da die Ergebnisse von 7)+8) deutlich besser sind als die Benchmarks übers Netzwerk könnte es hier evtl. ein Problem geben, aber welches? Es liegt nicht am Protokoll (da SMB/FTP/HTTP alle nicht berauschend sind), MTU hatte auch nix gebracht.

Ich wundere mich auch wie es andere DS210+-Benchmarks auf über 100MB/s Read und bis 70MB Write (über LAN!) schaffen wenn ich mit Dateitransfers innerhalb der DS nur ca. 50MB/s (mit cp + tar) hinbekomme. Der verbauten HD204UI Benchmarks liegen bei ca. 130MB/s Read/Write und sollten (sofern es nicht ein Problem im Zusammenspiel mit der DS gibt) eigentlich nicht das Nadelöhr sein.

Wäre toll wenn jemand einen Tip hat warum mein DS so lahmt!

Danke schonmal,

Markus

ich habe mir jetzt auch eine DS210+ gegönnt, allerdings habe ich massive Probleme mit den Durchsatzraten insbesondere beim Schreiben. Hab bereits alles mögliche was ich hier im Forum gefunden habe ausprobiert und weiss so langsam nicht mehr weiter, hoffe daher dass hier jemand einen Tip hat.

Das Problem sieht man am besten an den folgenden Benchmark-Ergebnissen. Write-Performance mit ca. 12MB/s ist übel, insbesondere verstehe ich nicht warum beim ATTO-Benchmark die Write-Performance ab 64kB Blockgröße drastisch einbricht.

Read-Performance von 37MB/s ist auch deutlich unter den Benchmarks diverser Reviews und von Synology.

Quick Facts zur Hardware:

- PC ASUS P4P800 Board mit GB-LAN (3C940 Chip), Intel P4 2.6GHz, WinXP

- TP-Link TL-SG1005G GB-Switch, CAT5 Kabel

- DS210+ mit DSM 3.0-1340

- 2x Samsung HD204UI (ohne /Z4!, also 512b Blöcke) als RAID1

- Systempartition ext3, Volume1 ext4 Filesystem (so automatisch bei Erstinstallation angelegt, warum?)

Information von "parted":

Rich (BBCode):

Model: SAMSUNG HD204UI (scsi)

Disk /dev/hda: 1953514584kiB

Sector size (logical/physical): 512B/512B

Partition Table: msdos

Number Start End Size Type File system Flags

1 128kiB 2490368kiB 2490240kiB primary ext3 raid

2 2490368kiB 4587520kiB 2097152kiB primary linux-swap(v1) raid

3 4718592kiB 1953512032kiB 1948793441kiB primary raidInformation von "fdisk -l -u":

Rich (BBCode):

Disk /dev/sda: 2000.3 GB, 2000398934016 bytes

255 heads, 63 sectors/track, 243201 cylinders, total 3907029168 sectors

Units = sectors of 1 * 512 = 512 bytes

Device Boot Start End Blocks Id System

/dev/sda1 256 4980735 2490240 fd Linux raid autodetect

Partition 1 does not end on cylinder boundary

/dev/sda2 4980736 9175039 2097152 fd Linux raid autodetect

Partition 2 does not end on cylinder boundary

/dev/sda3 9437184 3907024064 1948793440+ fd Linux raid autodetect

Disk /dev/sdb: 2000.3 GB, 2000398934016 bytes

255 heads, 63 sectors/track, 243201 cylinders, total 3907029168 sectors

Units = sectors of 1 * 512 = 512 bytes

Device Boot Start End Blocks Id System

/dev/sdb1 256 4980735 2490240 fd Linux raid autodetect

Partition 1 does not end on cylinder boundary

/dev/sdb2 4980736 9175039 2097152 fd Linux raid autodetect

Partition 2 does not end on cylinder boundary

/dev/sdb3 9437184 3907024064 1948793440+ fd Linux raid autodetectWas ich bisher ausprobiert/überprüft habe:

1) Firewall abgechaltet -> kein Effekt

2) DS210+ direkt am PC ohne Switch -> kein Effekt

3) MTU/Max.FrameSize von 1514 auf Jumboframes 4000 erhöht (PC+NAS) -> kein Effekt

4) FTP statt SMB: Write 15MB/s, Read 18MB/s bei einer 720MB Datei

5) HTTP statt SMB: Write 20MB/s, Read 12MB/s bei einer 720MB Datei

6) laut obigen Infos sollten die Partitionen auf 4k Blockgrenzen liegen, somit ok.

7) auf der DS: 720MB Dateien mit cp kopiert: Durchschnitt Read+Write = 1440MB/28s = 51MB/s

8) auf der DS: 6x720MB Dateien mit tar zusammengefasst: Durchschnitt Read+Write = 8640MB/190s = 45MB/s

9) Resource-Monitor gecheckt: keine Jobs die CPU wegfressen, DS ist idle wenn keine Fileoperationen laufen

Da die Ergebnisse von 7)+8) deutlich besser sind als die Benchmarks übers Netzwerk könnte es hier evtl. ein Problem geben, aber welches? Es liegt nicht am Protokoll (da SMB/FTP/HTTP alle nicht berauschend sind), MTU hatte auch nix gebracht.

Ich wundere mich auch wie es andere DS210+-Benchmarks auf über 100MB/s Read und bis 70MB Write (über LAN!) schaffen wenn ich mit Dateitransfers innerhalb der DS nur ca. 50MB/s (mit cp + tar) hinbekomme. Der verbauten HD204UI Benchmarks liegen bei ca. 130MB/s Read/Write und sollten (sofern es nicht ein Problem im Zusammenspiel mit der DS gibt) eigentlich nicht das Nadelöhr sein.

Wäre toll wenn jemand einen Tip hat warum mein DS so lahmt!

Danke schonmal,

Markus