Hallo zusammen,

ich nutze zur Sicherung meiner DS218+ Hype Backup auf externen USB HDDs. Das klappt auch. Backup wird nur alle paar Wochen mal gemacht, das reicht mir.

Eine externe HDD sichert die kompletten DSM Ordner, die andere sichert nur nochmal einen wichtigen Ordner auf der DS.

Soweit so gut.

Mein Problem ist das ich denke, entweder was falsch eingestellt zu haben oder irgendwas läuft faul.

Das Backup dauert bei mir immer ewig.

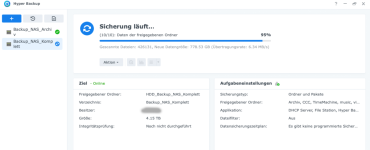

Datenübertragung zwischen 3 und 15 MB/s. Außerdem zeigt er die "Neue Dateigröße" immer recht hoch an. Wenn ich richtig gelesen habe sind das die Änderung seit dem letzten Backup. Aktuell sind es über 1TB. Ich habe aber nie im Leben über 1TB an Daten verändert seit dem letzten Backup.

Früher hatte ich als Backupmethode Einzelversionen, weil ich gerne die Rohdateien direkt auf der HDD haben wollte. Mittlerweile habe ich aber das Standardformat gewählt (Container) weil ich gelesen hatte, dass das schneller gehen soll.

Anbei ein Screenshot.

Kann ich das irgendwie noch beschleunigen? Ich würde an sich gern öfters die externe Sicherung machen. Nur habe ich keine Lust, immer 2-3 Tage zu warten.

Außerdem hätte ich an sich auch gerne ein paar Versionen. Aber meine externe HDD ist 5TB und intern in der DS sind aktuell 3,5TB belegt (Hyperbackup zeigt komischerweise 4,1TB an). Denke viele Versionen passen da nicht drauf. Bin mir nicht ganz sicher, wie man die Backupaufgabe optimal einstellt.

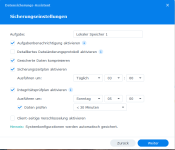

An sich habe ich die Verschlüsselung eingeschaltet, Versionierung auf 2 gestellt, alle Apps mit reingenommen usw.

Vielleicht zieht irgendeine Einstellung ja die Geschwindigkeit dermaßen herunter. Habe manchmal das gefühlt, dass es nicht ganz inkrementell abläuft. Was ist übrigens, wenn auf der externen HDD der Container beschädigt wird. Macht es da nicht eher Sinn, wieder auf Einzelversionen zu gehen?

Wie habt ihr das?

Vielen Dank im Voraus.

Manuel

ich nutze zur Sicherung meiner DS218+ Hype Backup auf externen USB HDDs. Das klappt auch. Backup wird nur alle paar Wochen mal gemacht, das reicht mir.

Eine externe HDD sichert die kompletten DSM Ordner, die andere sichert nur nochmal einen wichtigen Ordner auf der DS.

Soweit so gut.

Mein Problem ist das ich denke, entweder was falsch eingestellt zu haben oder irgendwas läuft faul.

Das Backup dauert bei mir immer ewig.

Datenübertragung zwischen 3 und 15 MB/s. Außerdem zeigt er die "Neue Dateigröße" immer recht hoch an. Wenn ich richtig gelesen habe sind das die Änderung seit dem letzten Backup. Aktuell sind es über 1TB. Ich habe aber nie im Leben über 1TB an Daten verändert seit dem letzten Backup.

Früher hatte ich als Backupmethode Einzelversionen, weil ich gerne die Rohdateien direkt auf der HDD haben wollte. Mittlerweile habe ich aber das Standardformat gewählt (Container) weil ich gelesen hatte, dass das schneller gehen soll.

Anbei ein Screenshot.

Kann ich das irgendwie noch beschleunigen? Ich würde an sich gern öfters die externe Sicherung machen. Nur habe ich keine Lust, immer 2-3 Tage zu warten.

Außerdem hätte ich an sich auch gerne ein paar Versionen. Aber meine externe HDD ist 5TB und intern in der DS sind aktuell 3,5TB belegt (Hyperbackup zeigt komischerweise 4,1TB an). Denke viele Versionen passen da nicht drauf. Bin mir nicht ganz sicher, wie man die Backupaufgabe optimal einstellt.

An sich habe ich die Verschlüsselung eingeschaltet, Versionierung auf 2 gestellt, alle Apps mit reingenommen usw.

Vielleicht zieht irgendeine Einstellung ja die Geschwindigkeit dermaßen herunter. Habe manchmal das gefühlt, dass es nicht ganz inkrementell abläuft. Was ist übrigens, wenn auf der externen HDD der Container beschädigt wird. Macht es da nicht eher Sinn, wieder auf Einzelversionen zu gehen?

Wie habt ihr das?

Vielen Dank im Voraus.

Manuel