- Registriert

- 17. Nov. 2010

- Beiträge

- 119

- Reaktionspunkte

- 19

- Punkte

- 18

Das System sichere ich separat. Ich verwende eine USB Platte (und keinen rsync Server) mit einem 3m USB-Kabel in einem feuerfesten Safe als primäre Sicherung für die freigegebenen Ordner. Mein Script schneidere ich daraufhin zu.

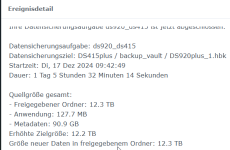

Das Problem von HyperBackup ist, vermute ich, der OverHead (Protokolleintrag nach jeder Datei) den es selbst verursacht und der ist mit einer anderen Kopiermethode nicht weg. Ich weiß nicht wie HyperBackup genau arbeitet aber der Schluß liegt nahe wenn man Post #10 ansieht.

Wenn jemand mit HyperBackup viele Kleinstdateien sichert und die Festplatte dabei nicht wie ein Maschinengewehr rattert bin ich der Erste den das interessieren würde. Ich habe allerdings keine Hoffnung mehr.

Ich habe allerdings keine Hoffnung mehr.

Das Problem von HyperBackup ist, vermute ich, der OverHead (Protokolleintrag nach jeder Datei) den es selbst verursacht und der ist mit einer anderen Kopiermethode nicht weg. Ich weiß nicht wie HyperBackup genau arbeitet aber der Schluß liegt nahe wenn man Post #10 ansieht.

Wenn jemand mit HyperBackup viele Kleinstdateien sichert und die Festplatte dabei nicht wie ein Maschinengewehr rattert bin ich der Erste den das interessieren würde.

Ich habe allerdings keine Hoffnung mehr.

Ich habe allerdings keine Hoffnung mehr.

Zuletzt bearbeitet von einem Moderator: