- Registriert

- 25. Nov. 2022

- Beiträge

- 5.392

- Reaktionspunkte

- 3.162

- Punkte

- 334

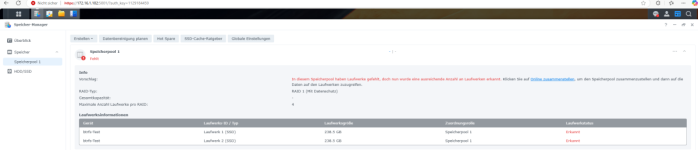

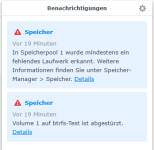

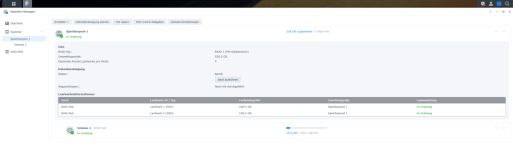

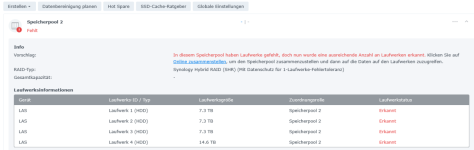

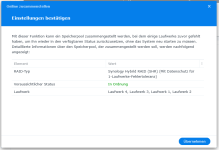

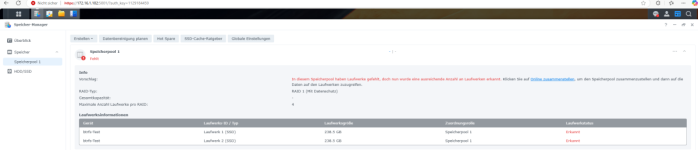

Ich habe allerlei Tests durchgeführt und sehr viele Fehlermeldungen im Speicher-Manager erhalten, die ich im Ernstfall nie sehen möchte.

Allerdings ist es mir nicht gelungen den Fehlerstatus von @knilch mit "Volume ist schreibgeschützt" zu provozieren.

Ich würde folgendes Vorgehen nach den Tests vorschlagen.

Folgendes notieren:

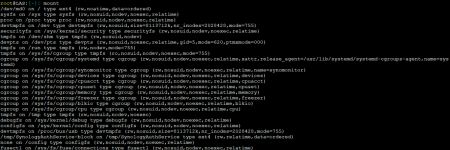

df -h

mount | grep volume2

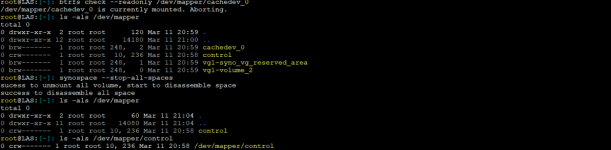

Danach folgende Befehle in der Console als Root ausführen:

btrfs scrub start /volume2

btrfs scrub status /volume2 (Status prüfen und Beendigung abwarten)

synospace --stop-all-spaces (Status im Speicher-Manager prüfen und notieren, falls anders lautend)

synospace --start-all-spaces (Status im Speicher-Manager nochmals prüfen)

Allerdings ist es mir nicht gelungen den Fehlerstatus von @knilch mit "Volume ist schreibgeschützt" zu provozieren.

Ich würde folgendes Vorgehen nach den Tests vorschlagen.

Folgendes notieren:

df -h

mount | grep volume2

Danach folgende Befehle in der Console als Root ausführen:

btrfs scrub start /volume2

btrfs scrub status /volume2 (Status prüfen und Beendigung abwarten)

synospace --stop-all-spaces (Status im Speicher-Manager prüfen und notieren, falls anders lautend)

synospace --start-all-spaces (Status im Speicher-Manager nochmals prüfen)