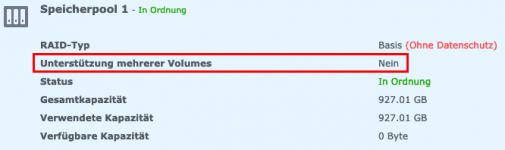

Erstmal danke für deine Antwort. Das Anlegen des Speicherpool als RAID 1 für beide SSD hat nach der Anleitung weiter oben geklappt und war auch kein Hexenwerk. Mein Problem ist, dass man leider auf diesem erstellten Speicherpool nur ein einziges Volume erstellen kann.

Ich hätte dafür aber gern die Unterstützung für mehrere Volumes. Ich hab schon alle möglichen Konstellationen ausprobiert, aber leider komme ich immer nur an den Punkt, dass ich nur ein einziges Volume anlegen kann. Meine Recherchen ergaben bis jetzt aber leider keinen weiteren Input dazu.

Nur nicht wundern, dass der RAID-Typ=Basis ist. Ich hatte das Ganze auch schon mit RAID 0/1 probiert, gleiches Ergebnis. So spare ich mir aber beim Ausprobieren immer den RAID-Build/Rebuild.

Ist das mit der Unterstützung für mehrere Volumes ne Sondersache von Synology? Kann ich mir zwar nicht vorstellen, aber man weiß ja nie.

@ctrlaltdelete Nutzt du das nur mit einem Volume oder wie ist das bei dir aufgeteilt?

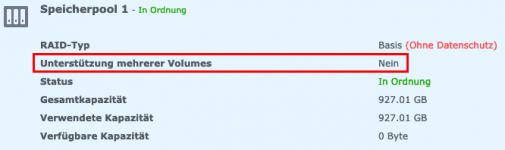

Ich hätte dafür aber gern die Unterstützung für mehrere Volumes. Ich hab schon alle möglichen Konstellationen ausprobiert, aber leider komme ich immer nur an den Punkt, dass ich nur ein einziges Volume anlegen kann. Meine Recherchen ergaben bis jetzt aber leider keinen weiteren Input dazu.

Nur nicht wundern, dass der RAID-Typ=Basis ist. Ich hatte das Ganze auch schon mit RAID 0/1 probiert, gleiches Ergebnis. So spare ich mir aber beim Ausprobieren immer den RAID-Build/Rebuild.

Ist das mit der Unterstützung für mehrere Volumes ne Sondersache von Synology? Kann ich mir zwar nicht vorstellen, aber man weiß ja nie.

@ctrlaltdelete Nutzt du das nur mit einem Volume oder wie ist das bei dir aufgeteilt?

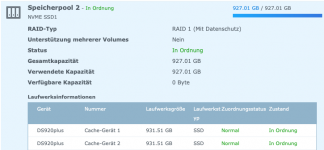

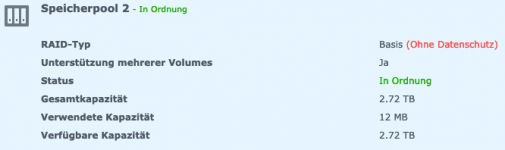

Da scheint sich meine Vermutung ja zu bestätigen. Synology kocht bei ihrem SHR auch nur mit Wasser

Da scheint sich meine Vermutung ja zu bestätigen. Synology kocht bei ihrem SHR auch nur mit Wasser

Ich habe mich mal im Schnelldurchlauf durch deinen Link aus

Ich habe mich mal im Schnelldurchlauf durch deinen Link aus