- Mitglied seit

- 02. Apr 2014

- Beiträge

- 384

- Punkte für Reaktionen

- 40

- Punkte

- 34

Übrigens, laut speicher.de ist "overraming" kein Problem.

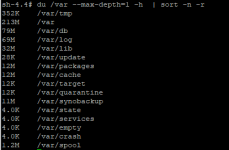

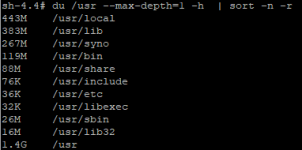

Dann wäre es eine Lösung eine 7.9GB root Partition zu haben.Ja gut, kann schon sein, daß da am Ende Hyperbackup immer auf irgendeinem Weg zumindest wärend dem Backup Temporär in die Systempartition hinein bieselt