Hallo,

derzeit schlage ich mich mit demselben Problem herum:

DS#1 = DS 415+ mit DSM 6.1, 4 x WD Red 4,0 TB, RAID5

DS#2 = DS 413 mit DSM 6.1, 4 x WD Red 3,0 TB, SHR

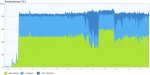

Ich will DS#2 komplett sichern ca. 5 TByte Daten. Drei Szenarien habe ich bisher angestartet und mehrere Stunden laufen lassen, um den Durchsatz zu messen. Alles ohne Krypto oder Kompression.

Sicherungsaufgabe 1:

DS#2 HyperBackup -> Remote Synology NAS (DS#1 HyperVault)

Durchsatz: 14,0 MByte/sec, voraussichtliche Dauer: 99,2 h = 4,1 Tage

Sicherungsaufgabe 2:

DS#2 HyperBackup -> lokaler freigegebener Ordner und externer Speicher (eSata)

Durchsatz: 12,9 MByte/sec, voraussichtliche Dauer: 107,7 h = 4,5 Tage

Sicherungsaufgabe 3:

DS#2 HyperBackup -> lokale Datenkopie (eSata)

Durchsatz: 30,9 MByte/sec, voraussichtliche Dauer: 44,9 h = 1,9 Tage

Das Legacy-Modell auf lokalen Speicher (eSata) gewinnt eindeutig. Wobei ich 30,9 MByte/sec nicht gerade atemberaubend finde.

Sieht hier jemand noch irgendeine beschleunigende Maßnahme auf Basis von HyperBackup?

Hat jemand Erfahrung mit Ultimate Backup und kann etwas zu dem damit erzielbaren Durchsatz sagen?

Gruß

KriKrack