- Mitglied seit

- 29. Mai 2022

- Beiträge

- 18

- Punkte für Reaktionen

- 2

- Punkte

- 3

Hallo, ich hoffe das ist hier das richtige Unterforum für das Thema.

Meine DS410j arbeitete bis vor kurzem problemlos mit 4x2TB (RAID5). Eine von vier Platten meldete vor ein paar Tagen viele defekte Sektoren (wurde aber noch als "healthy" angezeigt). Ich habe Ersatz bestellt, das NAS heruntergefahren, und die Platte ausgewechselt.

Danach hat das NAS nicht mehr gebootet. Die Power LED hat einige Minuten geblinkt. Nach einer Weile hat die Power LED durchgängig geleuchtet, and die Status LED hat schnell orange geblinkt und das NAS gepiept. Gleichzeitig waren die Festplatten LEDs grün.

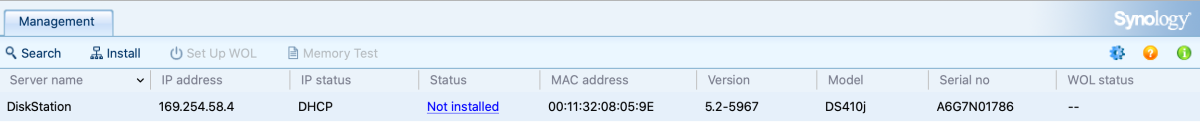

Das NAS taucht im Netzwerk mit dem richtigen Hostnamen auf. Die Weboberfläche ist allerdings nicht erreichbar, ping geht nicht und der DSAssistant findet das Gerät auch nicht.

Der Versuch mit einzelnen Platten zu booten, oder mit den 3 guten alten Platten ohne die neue Platte, oder in der ursprünglichen Konfiguration mit den 4 alten Platten, führt immer zum gleichen Ergebnis.

Booten ohne Festplatte geht soweit. Das NAS taucht im Netzwerk mit dem Standard Hostnamen "Disk Station" auf. Status LED ist grün. Ping funktioniert (zumindest kurzzeitig; oft gehen nur ein paar Pings, bevor das NAS wieder nicht nicht mehr antwortet). DSAssistant findet das NAS. Aber beim Versuch, das NAS neu zu initialisieren bricht die Verbindung ab.

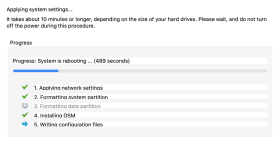

Neu initialisieren mit nur der neuen Platte hat einmal funktioniert, aber beim Neustart dann Verbindungsabbruch.

Nach einer Pause über Nacht (vom Netz getrennt) habe ich es heute wieder mit den ursprünglichen 4 Platten probiert. Erstaunlicher Weise hat das NAS gebootet und ich konnte mich einloggen. Das Volume wurde as "degraded" angezeigt (es kamen auch diverse Statusnachrichten und -emails: "Volume 1 on DSDemmel has entered degraded mode [3/4]", "Consistency check of system volume (Swap) on DSDemmel is complete", "iSCSI LUN of Disk Group on DSDemmel has failed"). Auch wenn alle 4 Platten als "healthy" angezeigt wurden, wurde Disk 2 (die mit den fehlerhaften Sektoren, die getauscht werden soll) aus dem Verbund geworfen. Bei Disk 3 und 4 stand außerdem "Systempartition fehlerhaft", bei Disk 1 war sie wohl ok. Ein einfacher Neustart hat auch funktioniert.

Nachdem ich aber dann die Disk 2 wieder gewechselt hatte (im ausgeschalteten Zustand), um das RAID reparieren zu können, war es wieder wie zuvor, das NAS hat minutenlang gebootet um dann mit orange blinkender LED zu piepen und nicht erreichbar zu sein. Diverse Varianten und Plattenkombinationen führen wie gestern zum gleichen Ergebnis.

Hat irgendwer eine Idee, was hier los sein könnte? In einem anderen Forenbeitrag hatte jemand berichtet, dass in so einem Fall ein neues Netzteil helfen könnte. Ist das plausibel?

Meine DSM Version ist 5.2-5967 Update 9 (aktuellste für diese DS). Die Hardware ist ja schon älter; vielleicht ist es Zeit, eine neue DS anzuschaffen. Kann ich das (degradete) RAID Array in einer neuen DiskStation (z.B. DS420j) einsetzen und dort reparieren / verwenden?

Als ich gestern kurzzeitig wieder Zugriff hatte, hab ich die Konfiguration gesichert. Außerdem ist ein Backup der DS auf eine externe USB Festplatte vorhanden (2x wöchentlich; sollte alle relevanten Daten enthalten).

Meine DS410j arbeitete bis vor kurzem problemlos mit 4x2TB (RAID5). Eine von vier Platten meldete vor ein paar Tagen viele defekte Sektoren (wurde aber noch als "healthy" angezeigt). Ich habe Ersatz bestellt, das NAS heruntergefahren, und die Platte ausgewechselt.

Danach hat das NAS nicht mehr gebootet. Die Power LED hat einige Minuten geblinkt. Nach einer Weile hat die Power LED durchgängig geleuchtet, and die Status LED hat schnell orange geblinkt und das NAS gepiept. Gleichzeitig waren die Festplatten LEDs grün.

Das NAS taucht im Netzwerk mit dem richtigen Hostnamen auf. Die Weboberfläche ist allerdings nicht erreichbar, ping geht nicht und der DSAssistant findet das Gerät auch nicht.

Der Versuch mit einzelnen Platten zu booten, oder mit den 3 guten alten Platten ohne die neue Platte, oder in der ursprünglichen Konfiguration mit den 4 alten Platten, führt immer zum gleichen Ergebnis.

Booten ohne Festplatte geht soweit. Das NAS taucht im Netzwerk mit dem Standard Hostnamen "Disk Station" auf. Status LED ist grün. Ping funktioniert (zumindest kurzzeitig; oft gehen nur ein paar Pings, bevor das NAS wieder nicht nicht mehr antwortet). DSAssistant findet das NAS. Aber beim Versuch, das NAS neu zu initialisieren bricht die Verbindung ab.

Neu initialisieren mit nur der neuen Platte hat einmal funktioniert, aber beim Neustart dann Verbindungsabbruch.

Nach einer Pause über Nacht (vom Netz getrennt) habe ich es heute wieder mit den ursprünglichen 4 Platten probiert. Erstaunlicher Weise hat das NAS gebootet und ich konnte mich einloggen. Das Volume wurde as "degraded" angezeigt (es kamen auch diverse Statusnachrichten und -emails: "Volume 1 on DSDemmel has entered degraded mode [3/4]", "Consistency check of system volume (Swap) on DSDemmel is complete", "iSCSI LUN of Disk Group on DSDemmel has failed"). Auch wenn alle 4 Platten als "healthy" angezeigt wurden, wurde Disk 2 (die mit den fehlerhaften Sektoren, die getauscht werden soll) aus dem Verbund geworfen. Bei Disk 3 und 4 stand außerdem "Systempartition fehlerhaft", bei Disk 1 war sie wohl ok. Ein einfacher Neustart hat auch funktioniert.

Nachdem ich aber dann die Disk 2 wieder gewechselt hatte (im ausgeschalteten Zustand), um das RAID reparieren zu können, war es wieder wie zuvor, das NAS hat minutenlang gebootet um dann mit orange blinkender LED zu piepen und nicht erreichbar zu sein. Diverse Varianten und Plattenkombinationen führen wie gestern zum gleichen Ergebnis.

Hat irgendwer eine Idee, was hier los sein könnte? In einem anderen Forenbeitrag hatte jemand berichtet, dass in so einem Fall ein neues Netzteil helfen könnte. Ist das plausibel?

Meine DSM Version ist 5.2-5967 Update 9 (aktuellste für diese DS). Die Hardware ist ja schon älter; vielleicht ist es Zeit, eine neue DS anzuschaffen. Kann ich das (degradete) RAID Array in einer neuen DiskStation (z.B. DS420j) einsetzen und dort reparieren / verwenden?

Als ich gestern kurzzeitig wieder Zugriff hatte, hab ich die Konfiguration gesichert. Außerdem ist ein Backup der DS auf eine externe USB Festplatte vorhanden (2x wöchentlich; sollte alle relevanten Daten enthalten).