- Mitglied seit

- 05. Mrz 2013

- Beiträge

- 2.152

- Punkte für Reaktionen

- 741

- Punkte

- 154

Da ja in der DSM 7.2.1 die SMART-Werte nicht mehr direkt zu erreichen sind, hier ein Ansatz über einen Docker-Container mit scrutiny

https://github.com/AnalogJ/scrutiny

Mein Dank geht an @plang.pl der mit seinem Post meinen Spieltrieb geweckt hat.

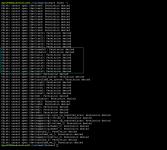

Hier in aller Kürze meine docker-compose.yml:

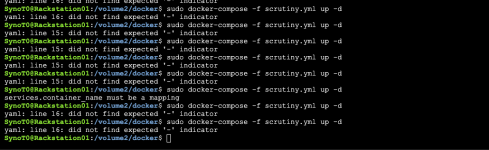

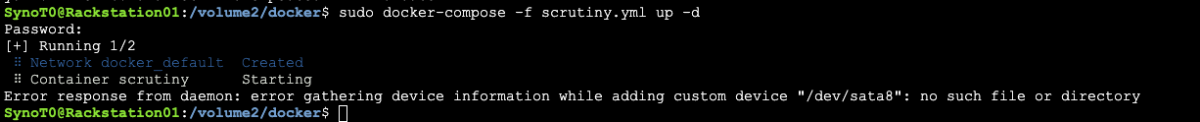

Da das - natürlich - auf der Syno nicht so einfach mit den Devices in der docker-compose läuft, wie man sich wünscht, hab ich eine collector.yaml erstellen müssen. Diese muss im config-Ordner abgelegt werden:

Diese ist für eine DS918+, bei anderen Modellen müsst ihr die Typen eventuell anpassen.

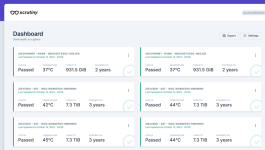

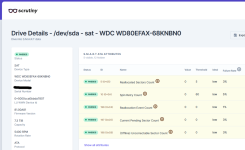

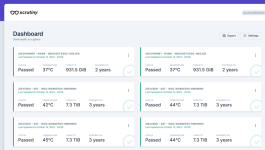

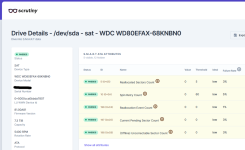

Das Ganze sieht dann so aus:

https://github.com/AnalogJ/scrutiny

Mein Dank geht an @plang.pl der mit seinem Post meinen Spieltrieb geweckt hat.

Hier in aller Kürze meine docker-compose.yml:

Code:

version: '3.5'

services:

scrutiny:

container_name: scrutiny

image: ghcr.io/analogj/scrutiny:master-omnibus

cap_add:

- SYS_RAWIO

- SYS_ADMIN

ports:

- "8080:8080"

- "8086:8086"

volumes:

- /run/udev:/run/udev:ro

- /volume1/docker/scrutiny/config:/opt/scrutiny/config

- /volume1/docker/scrutiny/influxdb:/opt/scrutiny/influxdbDa das - natürlich - auf der Syno nicht so einfach mit den Devices in der docker-compose läuft, wie man sich wünscht, hab ich eine collector.yaml erstellen müssen. Diese muss im config-Ordner abgelegt werden:

Code:

devices:

- device: /dev/sda

type: 'sat'

- device: /dev/sdb

type: 'sat'

- device: /dev/sdc

type: 'sat'

- device: /dev/sdd

type: 'sat'

- device: /dev/nvme0

type: 'nvme'

- device: /dev/nvme1

type: 'nvme'Diese ist für eine DS918+, bei anderen Modellen müsst ihr die Typen eventuell anpassen.

Das Ganze sieht dann so aus: