lvdisplay

--- Logical volume ---

LV Path /dev/shared_cache_vg1/syno_vg_reserved_area

LV Name syno_vg_reserved_area

VG Name shared_cache_vg1

LV UUID q6oVNe-dcq1-JD0y-j3EU-Ztib-KkK6-ccR8cJ

LV Write Access read/write

LV Creation host, time ,

LV Status available

# open 0

LV Size 12.00 MiB

Current LE 3

Segments 1

Allocation inherit

Read ahead sectors auto

- currently set to 384

Block device 252:2

--- Logical volume ---

LV Path /dev/shared_cache_vg1/alloc_cache_1

LV Name alloc_cache_1

VG Name shared_cache_vg1

LV UUID IzyPAY-TDkK-ERKO-JTPn-4dZu-Azd5-EE71eh

LV Write Access read/write

LV Creation host, time ,

LV Status available

# open 1

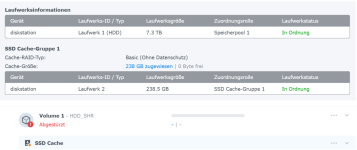

LV Size 238.00 GiB

Current LE 60928

Segments 1

Allocation inherit

Read ahead sectors auto

- currently set to 384

Block device 252:3

Couldn't find device with uuid MnKLNM-keuI-1nIF-KC43-3OEq-y7mL-XOJCIa.

--- Logical volume ---

LV Path /dev/vg1/syno_vg_reserved_area

LV Name syno_vg_reserved_area

VG Name vg1

LV UUID doXW2K-i0qb-bXNq-Iye0-pUxG-K8Iv-dIrY3k

LV Write Access read/write

LV Creation host, time ,

LV Status available

# open 0

LV Size 12.00 MiB

Current LE 3

Segments 1

Allocation inherit

Read ahead sectors auto

- currently set to 384

Block device 252:0

--- Logical volume ---

LV Path /dev/vg1/volume_1

LV Name volume_1

VG Name vg1

LV UUID tPAyqq-jOyP-QfEE-fkxD-yvEJ-1SyT-xyq57W

LV Write Access read/write

LV Creation host, time ,

LV Status available

# open 1

LV Size 7.27 TiB

Current LE 1905119

Segments 3

Allocation inherit

Read ahead sectors auto

- currently set to 384

Block device 252:1

Mount-Point prüfen

Mount-Point prüfen Nächste Schritte

Nächste Schritte Status des RAID-Verbunds checken:

Status des RAID-Verbunds checken: LVM aktivieren, falls es deaktiviert ist:

LVM aktivieren, falls es deaktiviert ist: Manuelles Mounten versuchen:

Manuelles Mounten versuchen: Btrfs-Dateisystem prüfen:

Btrfs-Dateisystem prüfen: