Leider bin ich den Loop anscheinend doch noch nicht losgeworden. In manchen meiner Verzeichnisse durchlaufen die gleichen Dokumente immer wieder den Prozess und werden (bereits umbenannt) immer wieder verarbeitet und in _BACKUP abgelegt und wieder neu prozessiert.

Das sieht man auch daran, dass die noch zu verarbeitenden Dateien auch mal wieder mehr werden obwohl keine neuen Dateien eingestellt wurden. Nach langem rauf und runter schwankt es gerade zwischen 5-6 noch zu verarbeitenden Dateien und "Alles Erledigt" hin und her. Wenn ich heute z.B. 50 Dokumente gescannt habe, steigt der globale Zähler um mehr als 300 PDFs... Hat jemand eine Idee, woran das liegen könnte?

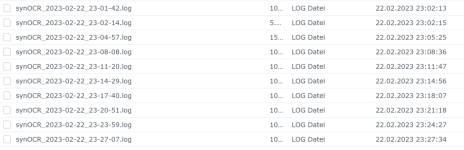

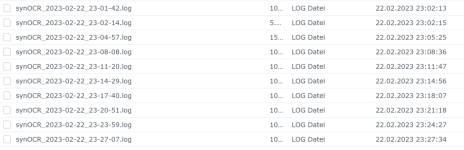

Hier ein Beispiel für den Ordner "Rechnungen" mit dem Profil "Rechnungen" (habe insgesamt 12 Ordner mit je gleichnamigem Profil, in die ich direkt mit einem Brother ADS 1700 scanne). Die Datei "23-01-03_#Benedikt#Rechnung.pdf" durchläuft den Prozess anscheinend immer und immer wieder und es werden alle paar Minuten neue Logs für die Datei geschrieben:

Das sind alles logs zur gleichen zu verarbeitenden Datei:

Das ganze findet in verschiedenen meiner 12 Ordner statt.

Kann es daran liegen, dass ich die Profile bearbeitet habe während die Überwachung lief und auch Dateien prozessiert wurden?

Hat jemand eine Idee, wie ich das vermeiden kann?

Vielen lieben Dank und Grüße

Benedikt

Das sieht man auch daran, dass die noch zu verarbeitenden Dateien auch mal wieder mehr werden obwohl keine neuen Dateien eingestellt wurden. Nach langem rauf und runter schwankt es gerade zwischen 5-6 noch zu verarbeitenden Dateien und "Alles Erledigt" hin und her. Wenn ich heute z.B. 50 Dokumente gescannt habe, steigt der globale Zähler um mehr als 300 PDFs... Hat jemand eine Idee, woran das liegen könnte?

Hier ein Beispiel für den Ordner "Rechnungen" mit dem Profil "Rechnungen" (habe insgesamt 12 Ordner mit je gleichnamigem Profil, in die ich direkt mit einem Brother ADS 1700 scanne). Die Datei "23-01-03_#Benedikt#Rechnung.pdf" durchläuft den Prozess anscheinend immer und immer wieder und es werden alle paar Minuten neue Logs für die Datei geschrieben:

Code:

-----------------------------------

| ==> installation info <== |

-----------------------------------

synOCR-user: synOCR

synOCR-user is admin: yes

synOCR-version: 1.3.0

Architecture: x86_64

DSM-build: 42962

Device: 718plus (3117383547)

current Profil: Rechnungen

monitor is running?: yes

DB-version: 8

used image (created): jbarlow83/ocrmypdf:v12.7.2 (2021-11-04T21:53:21)

document author:

used ocr-parameter (raw): -srd -l deu+eng

ocropt_array: -srd -l deu+eng

search prefix:

replace search prefix: yes

renaming syntax: §yocr-§mocr-§docr_§tag

Symbol for tag marking: #

target file handling: useCatDir

Document split pattern: SYNOCR-SEPARATOR-SHEET

split page handling: discard

clean up spaces: false

Date search method: use Python (BETA)

date found order: firstfound

source for filedate: ocr

ignored dates by search:

date range in past: 0 [absolute: 0]

date range in future: 0 [absolute: 0]

Docker test: OK

DSM notify to user: admin

Loglevel: normal

max. count of logfiles: 10

rotate backupfiles after: 30 days

Source directory: /volume1/scans/Rechnungen/

Target directory: /volume1/scans/Rechnungen/

Target temp directory: /volume1/scans/Rechnungen/synOCR_tmp_1677104452/

BackUp directory: /volume1/scans/Rechnungen/_BACKUP/

●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●

● ---------------------------------- ●

● | ==> RUN THE FUNCTIONS <== | ●

● ---------------------------------- ●

●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●

-----------------------------------------------------------------------------------

| check the python3 installation and the necessary modules: |

-----------------------------------------------------------------------------------

prepare_python: OK

●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●

● STEP 1 - RUN OCR / SPLIT FILES, IF NEEDED: ●

●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●

●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●

CURRENT FILE: ➜ 2023-01-03_#Benedikt#Rechnung.pdf

temp. target file: /tmp/tmp.qcc4xKS7Qp/2023-01-03_#Benedikt#Rechnung.pdf

-----------------------------------------------------------------------------------

| processing PDF @ OCRmyPDF: |

-----------------------------------------------------------------------------------

➜ OCRmyPDF-LOG:

WARNING: Error loading config file: .dockercfg: $HOME is not defined

reading file from standard input

1 skipping all processing on this page

Postprocessing...

/usr/local/lib/python3.9/dist-packages/pikepdf/models/metadata.py:377: UserWarning: The metadata field /CreationDate could not be copied to XMP

warn(msg)

Optimize ratio: 1.09 savings: 8.1%

Output sent to stdout

← OCRmyPDF-LOG-END

target file (OK): /tmp/tmp.qcc4xKS7Qp/2023-01-03_#Benedikt#Rechnung.pdf

-----------------------------------------------------------------------------------

| document split handling: |

-----------------------------------------------------------------------------------

no separator sheet found, or number of pages too small

-----------------------------------------------------------------------------------

| handle source file: |

-----------------------------------------------------------------------------------

➜ backup source file to: /volume1/scans/Rechnungen/_BACKUP/2023-01-03_#Benedikt#Rechnung.pdf

removed directory '/tmp/tmp.qcc4xKS7Qp'

Stats:

runtime last file: ➜ 00:00:12

runtime 1st step (all files): ➜ 00:00:13

●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●

● STEP 2 - SEARCH TAGS / RENAME / SORT: ●

●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●

●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●

CURRENT FILE: ➜ 2023-01-03_#Benedikt#Rechnung.pdf

-----------------------------------------------------------------------------------

| search tags in ocr text: |

-----------------------------------------------------------------------------------

source for tags is the list from the GUI

tag count: 11

Search by tag: "Rechnung" ➜ OK

Search by tag: "Lena" ➜ -

Search by tag: "Bruno" ➜ -

Search by tag: "Theo" ➜ -

Search by tag: "Ulrike" ➜ -

Search by tag: "Benedikt" ➜ OK

Search by tag: "Quittung" ➜ -

Search by tag: "Eckard Kiss" ➜ -

Search by tag: "Strickler" ➜ -

Search by tag: "Santo" ➜ -

Search by tag: "Centax" ➜ -

rename tag is: "#Benedikt#Rechnung"

-----------------------------------------------------------------------------------

| search for a valid date in ocr text: |

-----------------------------------------------------------------------------------

2023-02-22 23:21:07,273 - Date scanning started

2023-02-22 23:21:07,273 - Version: 1.03

2023-02-22 23:21:07,274 - Parameter minYear = 0

2023-02-22 23:21:07,274 - Parameter maxYear = 0

2023-02-22 23:21:07,274 - Parameter searchnearest = off

2023-02-22 23:21:07,274 - set searchnearest = off

2023-02-22 23:21:07,274 - Parameter fileWithTextFindings = /tmp/tmp.22ZtmI65kw/synOCR.txt

2023-02-22 23:21:07,275 - Start searching for alphanumerical and numerical dates......

2023-02-22 23:21:17,174 - finish searching for alphanumerical and numerical dates......

2023-02-22 23:21:17,174 - found 1 dates

2023-02-22 23:21:17,174 - found date 2023-01-03

2023-02-22 23:21:17,174 - Date scanning ended

Dates found: 1

check date ([yy]yy mm dd): 2023-01-03

➜ valid

day: 03

month:01

year: 2023

-----------------------------------------------------------------------------------

| rename and sort to target folder: |

-----------------------------------------------------------------------------------

➜ renaming:

apply renaming syntax ➜ 2023-01-03_#Benedikt#Rechnung

➜ insert metadata (use python PyPDF2)

used metadata:

➜ '/Author': '',

➜ '/Keywords': 'Benedikt, Rechnung',

➜ '/CreationDate': 'D:20230103'

target file: 2023-01-03_#Benedikt#Rechnung.pdf

-----------------------------------------------------------------------------------

| adjusts the attributes of the target file: |

-----------------------------------------------------------------------------------

➜ Adapt file date (Source: OCR)

-----------------------------------------------------------------------------------

| final tasks: |

-----------------------------------------------------------------------------------

INFO: (PushBullet-TOKEN not set)

Stats:

runtime last file: ➜ 00:00:14

pagecount last file: ➜ 1

file count profile : ➜ (profile Rechnungen) - 33 PDF's / 46 Pages processed up to now

file count total: ➜ 30313 PDF's / 32449 Pages processed up to now

cleanup:

delete tmp-files ...

removed '/tmp/tmp.22ZtmI65kw/synOCR.txt'

removed '/tmp/tmp.22ZtmI65kw/synOCR_filename.txt'

removed directory '/tmp/tmp.22ZtmI65kw'

removed '/volume1/scans/Rechnungen/synOCR_tmp_1677104452/2023-01-03_#Benedikt#Rechnung.pdf'

purge log files ...

delete 1 log files ( > 10 files)

delete 0 search files ( > 10 files)

purge backup files ...

delete 1 backup files ( > 30 days)

rmdir: removing directory, '/volume1/scans/Rechnungen/synOCR_tmp_1677104452/'

runtime all files: ➜ 00:00:27

●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●

● ---------------------------------- ●

● | ==> END OF FUNCTIONS <== | ●

● ---------------------------------- ●

●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●●Das sind alles logs zur gleichen zu verarbeitenden Datei:

Das ganze findet in verschiedenen meiner 12 Ordner statt.

Kann es daran liegen, dass ich die Profile bearbeitet habe während die Überwachung lief und auch Dateien prozessiert wurden?

Hat jemand eine Idee, wie ich das vermeiden kann?

Vielen lieben Dank und Grüße

Benedikt

.

.