Ja, aber nur ökologischer Dampf

Weiß schon, bin manchmal etwas impulsiv oder interpretiere in evtl. nicht böse gemeinte Aussagen irgendwelche Seitenhiebe oder Spitzen. Komisch nur, wenn ich schreib, kommen immer zig Leute an und sezieren meine Aussage, unterstellen was bei mir gar nicht zutrifft (z.B. Backups habe ich, wenn auch man nie zufrieden ist) und bei anderen ist man oberflächlicher.

Versuche ruhiger zu bleiben ...

Bei mir dauert die tägliche Sicherung meist 15-30 Minuten, je nach Auslastung vom NAS zu der Zeit - z.B. laufendes Scrubbing o.ä.

Ist Robocopy, was nur die Veränderungen vom Windows PC aufs NAS spiegelt und kurz darauf dann ein Snapshot.

Aber ist eben alles dabei bis hin zu den Outlook-Dateien (MOBackup Sicherungen).

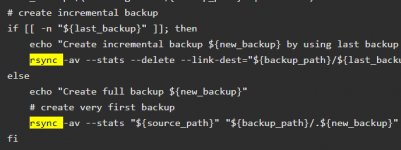

rsync direkt vom NAS zumindest zum clonen auf Backup-NAS muss ich erst etwas basteln und Erfahrungen sammeln ob das so zuverlässig ist wie robocopy, wäre natürlich schneller, wenn ich nicht den Windows-PC als "Vermittler" brauche, was im Prinzip auch ein Risiko ist.

Deshalb sind mir die Snapshots auch wichtig. Manipuliert z.B. jemand die Backup-Skripte könnte alles weg sein.

rsync hatte ich nur mal genommen, um ein Hardlinkbackup Archiv mit eben Hardlinks umzuziehen, da die USB-Festplatte damals zu klein wurde.

Oft können die Programme das nicht und kopieren dann wirklich alles x-fach.

Aber Hardlinkbackup verwende ich nun schon Jahre nicht mehr, seit ich das NAS habe

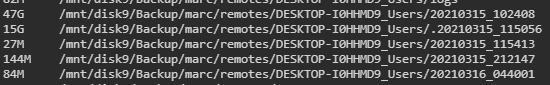

War einfach zu langsam - sehr schwankend von 30 Min. bis Stunden, wenn es die alten Sicherungen löschte. Heuer kam dann das Backup-NAS dazu.

Hab halt momentan alles mit robocopy, auch so aufgebaut, dass ich immer nur das Unterverzeichnis erweitern muss und dann rattert es alle Batch-Dateien ab und sammelt die Daten von C: / D: usw. zusammen. Ansonsten ist soweit möglich, aber leider nicht bei jedem Programm, immer alles an Daten zentral.

Verbessere ich das Skript, kann ich es halt relativ einfach auf die anderen mit Beyond Compare übernehmen. Deshalb habe ich momentan nix mir rsync, weil auf Windows nicht so einfach.

Muss ich mal wieder versuchen, brauchte man früher immer Cygwin o.ä.

Theoretisch könnte ich es automatisch laufen lassen, aber nur die Windows-PC laufen automatisch täglich, sogar das System selbst mit Veeam. Die Sicherung auf das Backup-NAS mache ich nach Bedarf. Ebenso das Spiegeln der Daten aufs Notebook, damit ich unterwegs die Grundausstattung habe - topaktuell brauche ich es dort nicht.

Habe dadurch auch noch einmal eine unabhängig Version an Daten, also quasi Backup.

Am schnellsten ist robocopy mit Sicherheit nicht, kopieren großer Dateien mit xx GB geht z.B. per Total Commander schneller.

Werde mal mit rsync Erfahrungen sammeln, danke für den Tipp, wie du es machst.

Man könnte so ein Archiv aufbauen, dass nicht verlorengeht - wie es bei den Snapshots aktuell ist, wenn man nicht gerade die HDDs in ein neues NAS mit umzieht und offiziell migriert. Geht mit robocopy zwar auch, Dateien in Verzeichnis mit aktuellen Datum erstellen (nur Hardlinks glaube nicht) und dann z.B. 14 Tage behalten, danach älteste löschen. Snapshot ist hier halt bequemer, da ich mehr einstellen kann. Letzte 30 Tage, 1 pro Woche / Monat / Jahr o.ä. behalten

Details zum System (RAM) bekommt man übrigens per:

sudo dmidecode

ggf. zuvor noch ein

sudo su -

So aber nun genug Offtopic.