Ob Daten korrupt bzw. einwandfrei sind oder nicht, kann kein Mensch zu 100% sicher über seine Daten sagen um dann zu behaupten ext4 ist sicherer und fehlerfrei, nur weil es das 20 Jahre - oder was weiß ich - länger gibt. Niemand weiß es wirklich !

Die Wahrscheinlichkeit mag möglicherweise für ext4 sprechen, nur was nützt einem das, wenn ich Features wie Snapshots benötige, weil ohne alles der reinste Krampf und Kampf ist. Ich will am Ende meines Lebens nicht 10 Jahre mit Backup Spielchen / Prüfungen etc. verbracht haben.

Man macht von Zeit zu Zeit Stichproben, mehr ist nicht möglich.

Da niemand bei mehr als 1 TB an Daten überhaupt den Aufwand für Hash-/Binär-Vergleiche o.ä. regelmäßig betreiben kann, interessiert das letztlich nicht. Ist alles nur Theorie ohne für den gewöhnlichen Anwender praktischen Nutzen. Wir sind nicht beim Militär o.ä. um sicherstellen, dass das Programm hinter dem red button korrekt abläuft und nicht vorher das Ziel vom Feind auf die eigene Basis verändert wurde.

Zudem kann der gespeicherte Hash auch wieder "leiden" / manipuliert werden - was also ist dann fehlerhaft, die Prüfsumme von vor 2 Jahren oder die Quelle ?

Müsste mal also auch alles wieder zig-fach an unterschiedlichen Orten speichern - alles total schwachsinnig, darüber nachzudenken.

Das beginnt schon beim Download einer Datei, wer vergleicht diese schon - wenn überhaupt entsprechende Dateien von der Quelle zur Verfügung gestellt werden.

Zudem müsste man das alles schließlich regelmäßig machen, die meisten machen es nicht einmal beim umkopieren von xx TB auf ein neues NAS, weils noch einmal 2-3 Wochen dauern würde (mal will die HDDs ja auch nicht unnötig quälen, sonst ist Bitrot etc. das kleinste Problem) und zu 99% eben einfach nichts passiert, wenn man mit guten Programmen kopiert und nicht dem Windows Explorer. Da gibt es selbst bei Abbrüchen während dem Kopieren kein Problem. Total Commander löscht z.B. unvollständige Dateien und Robocopy beginnt verlässlich wieder selbst bei 20 GB von 40 GB mitten in der Datei den Rest zu übertragen. Kann man gerne hinterher per Binärvergleich prüfen, wer es nicht glaubt.

Harzt-IVler hätten evtl. die Zeit - aber die haben kein Geld für die Technik und einige nicht ansatzweise das Wissen ...

Ich kann mich jedenfalls nicht tagtäglich rund um die Uhr damit beschäftigen, ob die Dateien noch den gleichen Hash wie vor 5 Jahren haben.

Wie gesagt, diese Prüfsummenvergleiche oder Binärvergleiche dauern ewig.

Es ist nicht immer so einfach, wie bei JPG-Fotos an Blöcken im Bild zu erkennen, dass der Download / Bestand Müll ist.

Wie will man bei x / xx GB Dateien erkennen, wenn ein Bit umgekippt ist - dann ruckelt halt ein Video o.ä. an einer bestimmte Stelle und das wars.

Wer denkt dann an schrottige Dateien bzw. prüft das hinterher stundenlang um sicher zu sein. Es wird somit als Verzögerung im LAN / WLAN abgestempelt.

Selbst viele Dateien wie Dokumente, Excel usw. werden sich bis zu einem Gewissen grad noch öffnen lassen, wer prüft ob überall nach 5 Jahren noch die gleichen Zahlen stehen ?

Die meisten Daten werden zudem sehr oft umgewälzt und lagern nicht einfach 10 Jahre im Schrank, oder werden defragmentiert - wo also soll unter normalem Umständen Bit Rot entstehen.

Wie oft werden größere Festplatten gekauft, neues NAS, alles umkopiert usw.

Also irgendwo ist einfach eine Grenze des Machbaren gegeben und daher ist es mühsig jahrelang darüber zu diskutieren.

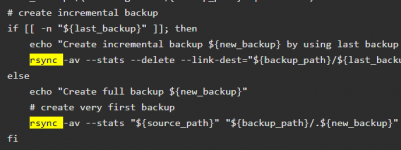

Ich mache nie inkrementelle Backups, um mir dann meine kompletten Daten aus 100 Verzeichnissen zusammensuchen zu müssen.

Das ist für mich kein Backup, sondern eine Zumutung - insbesondere dann, wenn man nur mit Skripten arbeitet und keiner Software, die einmal das alles wieder zusammenpuzzelt - was wieder ewig dauert, nichts für mich !

Wenn man nur seine paar Windows Daten wie Eigenen Dateien usw. sichern muss ist vieles einfacher und dann muss man sich auch keine großen Gedanken machen.

Selbst 250.000 Dateien hört sich viel an, ist es aber nicht - nicht wenig, aber auch nicht besonders viel.

Man kann auch nicht einfach behaupten 1 Mio. Dateien würde dann 24 Minuten dauern - das ist alles zu primitiv gedacht, die Situation und die Art der Dateien / Dateigrößen usw. spielt dann schon auch eine Rolle.

Auch zu behaupten, dann ist halt dein LAN usw. langsam - nein ist es nicht, es läuft auf Maximum, aber 10 GBit habe ich halt nicht.

Zudem hängt es immer davon ab, was abgeglichen wird.

LAN <-> LAN ist wesentlich langsamer als SSD vom lokalen PC -> LAN. Ja beides läuft letztlich übers LAN, aber wers nicht glaub, solls selbst testen - Vollduplex hin oder her. Vergleicht mal z.B. binär oder auch nur auf Vollständigkeit oder anhand der Dateigröße ohne tiefergehende Prüfung den Datenbestand mit z.B. Beyond Compare von zwei NAS oder von SSD zu NAS - was schneller geht.

Was häh ?

Wenn man behauptet es gibt Fehler / Probleme mit BTRFS, dann legt man diese entweder klar auf den Tisch oder schweigt.

Ansonsten lasse ich noch zu, konkret zu sagen, es beruht nicht auf eigenen Erfahrungen weil ich im Leben bislang nur ext4 nutze - deshalb der Link zu Google.

Aber nicht nach Hörensagen, weiterzutraschten es gäbe Probleme, ohne diese klar zu benennen ...

Wenn ich Probleme kenne, nenn ich diese - ansonsten weiß ich eben nix.

Ist das nun deutlich genug ?

Als Beispiel außer Snapshots, lass mal HardlinkBackup nach Löschregeln veraltete Sicherungen zu weniger als 2 TB löschen (am besten noch auf einer USB-Festplatte und nicht am NAS), das dauert mehr als 6 Minuten, selbst am NAS.

Das dauert in etwa so lange, wie es unter Windows dauert xxx GB zu löschen, egal ob per Dateimanger wie TC oder direkt per rd - vom Explorer brauchen wir gar nicht zu reden. Bis der anfängt dauert es oftmals länger als direkt per "Konsole". Programme wie HLB nutzen aber oft nur irgendeine Windows-API oder was weiß ich. Ist also kein Linux wo rekursives löschen evtl. grundsätzlich wesentlich schneller ist.

Für Windows ist das schließlich kein Unterschied, es löscht nicht 250.000 LNK-Dateien, sondern ob Hardlink oder nicht, nicht anders / schneller als bei jeder anderen Datei auch.

Ich hatte das alles schon mal und weiß was ich sage, das NAS habe ich nicht zum Spaß. Es ist nicht nur eine Sache der Kapazität, sondern auch der Performance.

Ich war froh, dass es Snapshots gibt, weil es mir massig Zeit sparte - auch wenn der Rechner nicht mein Händchen dazu braucht, aber er muss auch nicht umsonst Stunden rödeln. Leider haben auch Snapshots Grenzen, z.B. eben auf ein zweites NAS umziehen, geht nur per Replikation - aber nicht im nachhinein alle bisherigen Snapshots "kopieren" - sondern nur "zeitgleich" bei Quelle und Ziel erstellen lassen.

Ich rede jedenfalls von Vollbackups (mit Hardlinks), wie gesagt inkrementelle Backups sind für mich witzlos.

Zudem ist alles eine Frage der Menge der Daten, ob es Millionen Dateien sind oder nur die popeligen Eigenen Dateien, wovon 99% pro Tag unverändert bleibt.

Ich will mir die Arbeit einfach machen. Warum sollte ich inkrementell sichern, wenn rsync oder robocopy ein Mirror kann - löscht im Ziel alles was zu viel ist und ergänzt was fehlt. Benötigt auch nicht mehr Speicherplatz als inkrementell.

Anschließend einen Snapshot um diesen Stand gegen versehentliches Löschen zu fixieren und fertig.

Zum RAM, was hatte ich geschrieben ?

Die Labels erstellt oft genug erst der Händler selbst - wegen Garantiezuordnung usw. - soll da schlaue Händler geben, inbesondere bei geprüfter Ware und keiner Massenware, die einfach so vom Hersteller kommt und 1:1 weitergeschoben wird !

Ich will den technischen Beweis, auf Papier kann ich alles Schreiben drucken.

Man wäre ein vollkommener Trottel, wenn man alles glaubt, was auf Papier steht !

Ihr lest doch hier alle nur im Schnelldurchlauf - aber Hauptsache zurückschießen - aber so sind wohl die Deutschen.

In englischsprachigen Foren oder selbst bei Reddit läuft das alles wesentlich fachlicher ab und nicht nur Blubb Blubb von allen Seiten, Hauptsache jeder hat mal das Bein gehoben.

Schön auch, dass man ständig etwas annimmt - wo habe ich geschrieben ich hätte keine Backups ?

Ich habe 2 NAS und externe Festplatten - in die Cloud sichere ich nichts, da ich fremden meine Daten nicht anvertraue und es bei der Menge auch schlicht unmöglich wäre. Man kann sich auch nicht auf die Cloud 100%ig verlasse, siehe aktueller Brand. Zudem liegen die wichtigsten Daten noch auf PC / Notebook oder wären physisch vorhanden, wenn auch mit viel Arbeit verbunden.

Das Backup-NAS läuft aber nicht 24 Stunden, sondern je nachdem wieviel Daten sich änderten, wird mal wieder gespiegelt.

Das ist ja gerade der Sinn der Sache. Ich will bei einem Cyber-Angriff nicht alles verlieren.

Ja und jetzt kommt wieder, sichere extern - nun ein Ferienhaus in Frankreich habe ich nicht für NAS Nr. 3, Cloud ist unmöglich, dem Nachbarn vertraue ich nicht - wäre wenn ich nicht ein 50 m Kabel lege auch wieder die Internetleitung nötig, die bei der Menge selbst bei > 100 MBit nicht ausreicht.

Also dann kann ich mich noch so aufgeilen, was es alles gibt. 99% der Privatleute haben nicht einmal die Hälfte von dem, was die meisten hier an Technik herumstehen haben.

Nicht jeder benötigt Verschlüsselung im privaten Umfeld - man kann auch mehrere Pariser aufziehen - aber schön, dass man den Hinweis in die Runde wirft. Alles ausreizen und dann jammern, dass es langsam ist oder wenn man seine Daten wegen was auch immer, nicht mehr entschlüsselt bekommt.

Auf einem Notebook / USB-Stick o.ä., wenn man ein Schussel ist, ist Verschlüsselung schön und gut - aber wer mir meine Bude während dem Urlaub leer räumt, der kann auch mit Verschlüsselung genug Schaden anrichten.

Man könnte nun auch frech behaupten, es hängt davon ab, wieviel an Software verändert wurde ob ext4 oder btrfs.

Wer nichts ändert, weils die letzten 10-20 Jahre so war, lassen wirs lieber - setzt sich natürlich auch keinem erhöhten Risiko aus.

Der Fortschritt war noch nie frei von Risiko - aber wir sprechen hier von keiner 90% oder gar 10%igen Wahrscheinlichkeit das die Daten von NAS wegen btrfs hopsgehen!

Synology ist nicht so dumm, sich einem überdurchschnittlich hohem Risiko auszusetzen ... BTRFS unter die Leute zu werfen und dann weltweit verklagt zu werden. Es ist keine "Beta-Software" !

Auch Aussagen, ob BTRFS RAID xyz kann - was interessiert mich das - was nicht geht, erlaubt die Synology nicht.

Alle wollen immer schlauer sein, als dutzende oder hunderte Leute, deren täglicher Job das während der Produktentwicklung ist.

Da sagt keiner, hui BTRFS ist geil, bringen wir nächste Woche ein Produkt auf den Markt.

Bisschen getestet wird dann schon bei sowas elementaren, da muss ich Synology dann schon mal verteidigen - auch wenn ich nicht alles was Synology macht gut finde.