- Mitglied seit

- 28. Okt 2020

- Beiträge

- 15.083

- Punkte für Reaktionen

- 5.465

- Punkte

- 564

Ich habe mir eine Subdomain bei DDNSS.de gesichert. Zuerst war ich bei FreeDNS unterwegs. Da scheint aber im kostenlosen Account kein WildCard DNS möglich zu sein. Das brauche ich zwar eigentlich nicht, da ich alles nur intern nutze. Aber falls ich später mal von extern zugreifen will, möchte ich mir diese Option offen halten. Außerdem schaut DDNSS deutlich moderner aus.

acme.sh ist auch eingerichtet und läuft. Erstes Zertifikat wurde bereits gezogen und liegt im Docker-Unterordner. Also alles gut. Das erste manuelle Abholen des Zertifikats schlug fehl. Das zweite klappte dann allerdings. Keine Ahnung, warum es das erste Mal nicht hingehauen hat. Is mir aber auch egal

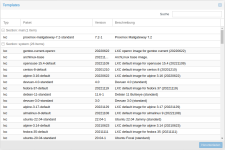

NGINX Proxy Manager (jc21/nginx-proxy-manager:latest) läuft auch (auf der gleichen VM). Nun die Quizfrage: Wie bekomme ich das Zertifikat, das im acme-Ordner liegt, darin eingebunden?

Ich habe bereits versucht, den acme Ordner auch in NGINX zu mounten. Aber ich scheitere daran, manuell ein Zertifikat einzubinden. Der Proxy Manager will immer ein neues LE-Zertifikat anfordern. @EDvonSchleck hast du hier vielleicht eine Ahnung?? Oder ist es in dem Fall doch besser, das Zertifikat direkt über den Proxy Manager zu erneuern? Der unterstützt aber halt deutlich weniger Anbieter und mein DDNSS wäre da auch nicht dabei.

acme.sh ist auch eingerichtet und läuft. Erstes Zertifikat wurde bereits gezogen und liegt im Docker-Unterordner. Also alles gut. Das erste manuelle Abholen des Zertifikats schlug fehl. Das zweite klappte dann allerdings. Keine Ahnung, warum es das erste Mal nicht hingehauen hat. Is mir aber auch egal

NGINX Proxy Manager (jc21/nginx-proxy-manager:latest) läuft auch (auf der gleichen VM). Nun die Quizfrage: Wie bekomme ich das Zertifikat, das im acme-Ordner liegt, darin eingebunden?

Ich habe bereits versucht, den acme Ordner auch in NGINX zu mounten. Aber ich scheitere daran, manuell ein Zertifikat einzubinden. Der Proxy Manager will immer ein neues LE-Zertifikat anfordern. @EDvonSchleck hast du hier vielleicht eine Ahnung?? Oder ist es in dem Fall doch besser, das Zertifikat direkt über den Proxy Manager zu erneuern? Der unterstützt aber halt deutlich weniger Anbieter und mein DDNSS wäre da auch nicht dabei.