HomeLab

- Ersteller plang.pl

- Erstellt am

-

Ab sofort steht euch hier im Forum die neue Add-on Verwaltung zur Verfügung – eine zentrale Plattform für alles rund um Erweiterungen und Add-ons für den DSM.

Damit haben wir einen Ort, an dem Lösungen von Nutzern mit der Community geteilt werden können. Über die Team Funktion können Projekte auch gemeinsam gepflegt werden.

Was die Add-on Verwaltung kann und wie es funktioniert findet Ihr hier

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

EDvonSchleck

Gesperrt

- Registriert

- 06. März 2018

- Beiträge

- 4.703

- Reaktionspunkte

- 1.122

- Punkte

- 214

- Registriert

- 28. Okt. 2020

- Beiträge

- 15.837

- Reaktionspunkte

- 6.057

- Punkte

- 589

Ich war mal wieder bei Mariushosting unterwegs und der hat sein Repertoire ordentlich aufgestockt. Von daher wollte ich einige Container, die er nun listet, testen. Von allen, die ich hier gleich nenne, habe ich vorher nie etwas gehört.

-dozzle, zeigt Container Logs schnell und unkompliziert an

-rapid, Kann Docker-Befehle ausführen (mit Auswahl, ist schwer zu beschreiben)

-WatchYourLan (IP-Scanner)

-yacht, Alternative zu Portainer

-homarr, Alternative zu heimdall

-Doku, Ressourcenverbrauch von Containern ansehen

-und ich habe RustDesk auf einen Container "geshrinkt"

Zum Glück hab ich für die ganzen Spielereien mittlerweile eine Test-VM

Backup hab ich aktuell noch so am Laufen:

AB4B sichert über SMB die Docker-Ordner der VMs weg. Ein paar Minuten vor dem Backup-Start läuft via Cron in der SQL-VM ein Script, welches einen SQL-Dump erstellt, der mitgesichert wird. Ich will ja eine konsistente Sicherung der Datenbank haben. Falls es jemanden interessiert: Sicherung der Datenbank "Test":

Der Proxmox sichert die VMs eigentätig via SMB aufs NAS. Ich habe auch schon die Sicherung mit dem AB4B Agent in den Maschinen getestet. Klappt auch super. Hier werde ich aber noch weiter testen: Ich habe schon den Proxmox Backup-Server als VM auf der DS installiert, aber noch nicht fertig eingerichtet. Und ich habe "Veeam Backup & Replication" auf der Win11-Maschine installiert, weil ich dachte, das kann den ganzen Proxmox mit VMs wegsichern. Kann es aber nicht. Da will ich noch testen, ob ich ggfs. die einzelnen VMs sichern kann, ohne darin einen Agent zu installieren.

Eigentlich wollte ich ja anfänglich nur die Dienste der DS auf den Proxmox umziehen. Aber ich habe hier und da und eigentlich überall gebastelt. Aktuell liegt gefühlt "alles in Schutt und Asche"

Is aber egal. Ich habe Backups

-dozzle, zeigt Container Logs schnell und unkompliziert an

-rapid, Kann Docker-Befehle ausführen (mit Auswahl, ist schwer zu beschreiben)

-WatchYourLan (IP-Scanner)

-yacht, Alternative zu Portainer

-homarr, Alternative zu heimdall

-Doku, Ressourcenverbrauch von Containern ansehen

-und ich habe RustDesk auf einen Container "geshrinkt"

Zum Glück hab ich für die ganzen Spielereien mittlerweile eine Test-VM

Backup hab ich aktuell noch so am Laufen:

AB4B sichert über SMB die Docker-Ordner der VMs weg. Ein paar Minuten vor dem Backup-Start läuft via Cron in der SQL-VM ein Script, welches einen SQL-Dump erstellt, der mitgesichert wird. Ich will ja eine konsistente Sicherung der Datenbank haben. Falls es jemanden interessiert: Sicherung der Datenbank "Test":

docker exec mariadb /usr/bin/mysqldump -u USER --password=PASS Test > /home/docker/Backup/mariadb/Test.sql.Der Proxmox sichert die VMs eigentätig via SMB aufs NAS. Ich habe auch schon die Sicherung mit dem AB4B Agent in den Maschinen getestet. Klappt auch super. Hier werde ich aber noch weiter testen: Ich habe schon den Proxmox Backup-Server als VM auf der DS installiert, aber noch nicht fertig eingerichtet. Und ich habe "Veeam Backup & Replication" auf der Win11-Maschine installiert, weil ich dachte, das kann den ganzen Proxmox mit VMs wegsichern. Kann es aber nicht. Da will ich noch testen, ob ich ggfs. die einzelnen VMs sichern kann, ohne darin einen Agent zu installieren.

Eigentlich wollte ich ja anfänglich nur die Dienste der DS auf den Proxmox umziehen. Aber ich habe hier und da und eigentlich überall gebastelt. Aktuell liegt gefühlt "alles in Schutt und Asche"

Is aber egal. Ich habe Backups

- Registriert

- 28. Okt. 2020

- Beiträge

- 15.837

- Reaktionspunkte

- 6.057

- Punkte

- 589

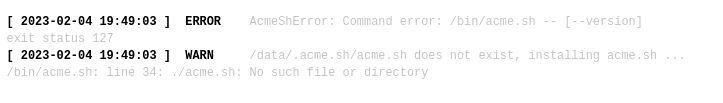

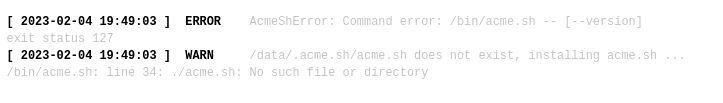

Mittlerweile hat das Aufsetzen des NGINX RP in v3 geklappt. Also mit acme.sh integriert. Allerdings erhalte ich nach dem Aufsetzen beim ersten Anmelden direkt einen Fehler im Log. Ich kann auch keine Zertifikate hinzufügen. Beim Klicken der Schaltflächen tut sich nix. Log:

Wenn hier keiner weiter weiß, mache ich ggfs. einen neuen Thread auf oder mach ein Issue auf Github auf.

Wenn hier keiner weiter weiß, mache ich ggfs. einen neuen Thread auf oder mach ein Issue auf Github auf.

- Registriert

- 28. Okt. 2020

- Beiträge

- 15.837

- Reaktionspunkte

- 6.057

- Punkte

- 589

Also ich habs abgeschlossen!

Zumindest das mit den Zertifikaten.

Ergebnisse:

-Wenn ich den NGINX RP in v3 starte ohne "/data" zu mounten, kommt kein Fehler im Log

->dennoch bleibt die Schaltfläche für Zertifikate ohne Funktion

-Image von jlesage getestet: ist wie das von jc21 in v2

-habe dann via certbot ein LE Zertifikat im NGINX RP (Container von jc21, in v2) angefragt mit 1800 sec Wartezeit

->ich habe ein gültiges Wildcard-Zertifikat, das vom RP verwaltet wird. Endlich! acme.sh brauche ich somit (vorerst) nicht mehr

Hier die Einstellungen:

Zumindest das mit den Zertifikaten.

Ergebnisse:

-Wenn ich den NGINX RP in v3 starte ohne "/data" zu mounten, kommt kein Fehler im Log

->dennoch bleibt die Schaltfläche für Zertifikate ohne Funktion

-Image von jlesage getestet: ist wie das von jc21 in v2

-habe dann via certbot ein LE Zertifikat im NGINX RP (Container von jc21, in v2) angefragt mit 1800 sec Wartezeit

->ich habe ein gültiges Wildcard-Zertifikat, das vom RP verwaltet wird. Endlich! acme.sh brauche ich somit (vorerst) nicht mehr

Hier die Einstellungen:

EDvonSchleck

Gesperrt

- Registriert

- 06. März 2018

- Beiträge

- 4.703

- Reaktionspunkte

- 1.122

- Punkte

- 214

Deine hohe Wartezeit von 1800 Sekunden ist mir nach wie vor ein Rätsel.

Die Tage von Cerbot im Nginx RP sind eh gezählt, genauso wie MariaDB/NySQL.

Schön das es zu deiner Zufriedenheit funktioniert.

Die Tage von Cerbot im Nginx RP sind eh gezählt, genauso wie MariaDB/NySQL.

Schön das es zu deiner Zufriedenheit funktioniert.

- Registriert

- 28. Okt. 2020

- Beiträge

- 15.837

- Reaktionspunkte

- 6.057

- Punkte

- 589

Ja, ist mir tatsächlich auch ein Rätsel. Hatte keine Berichte von anderen Usern gefunden, die das bei netcup berichteten.

Aber letzten Endes kann es mir ja egal sein, ob das Zertifikat 300sek oder eine halbe Stunde oder gar 3 Stunden für den Renew braucht. Läuft ja alles im Hintergrund.

Und ich weiß auch, dass das schon fast Legacy-Features sind, aber solange es hinhaut, bin ich zufrieden.

Wenn ich mal wieder viel Lust habe, versuch ich mich vielleicht noch mal dran. In naher Zukunft aber wahrscheinlich eher nicht.

Aber letzten Endes kann es mir ja egal sein, ob das Zertifikat 300sek oder eine halbe Stunde oder gar 3 Stunden für den Renew braucht. Läuft ja alles im Hintergrund.

Und ich weiß auch, dass das schon fast Legacy-Features sind, aber solange es hinhaut, bin ich zufrieden.

Wenn ich mal wieder viel Lust habe, versuch ich mich vielleicht noch mal dran. In naher Zukunft aber wahrscheinlich eher nicht.

EDvonSchleck

Gesperrt

- Registriert

- 06. März 2018

- Beiträge

- 4.703

- Reaktionspunkte

- 1.122

- Punkte

- 214

Mit Nginx RP v3 geht es auch irgendwie nicht voran, warum auch immer. Mal sehen, wie lange noch dauert. Dieses Jahr wohl nicht mehr...

- Registriert

- 28. Okt. 2020

- Beiträge

- 15.837

- Reaktionspunkte

- 6.057

- Punkte

- 589

Was ich noch zu #85 sagen muss:

Nach Start der Anforderung zeigt die Web UI nach einiger Zeit einen Fehler ("Bad Gateway"). Wenn man dann einen Blick auf die Zertifikate wirft, sieht man, dass man ein ungültiges erhalten hat. Wenn man es dann erneut versucht oder das Zertifikat erneuern will, sieht man im Log "Certbot already running". Wartet man aber die volle Sleep Zeit ab, hat man ein gültiges.

Nach Start der Anforderung zeigt die Web UI nach einiger Zeit einen Fehler ("Bad Gateway"). Wenn man dann einen Blick auf die Zertifikate wirft, sieht man, dass man ein ungültiges erhalten hat. Wenn man es dann erneut versucht oder das Zertifikat erneuern will, sieht man im Log "Certbot already running". Wartet man aber die volle Sleep Zeit ab, hat man ein gültiges.

Ich hatte zwar schon Rückmeldung gegeben, dass mittlerweile alles klappt. Weiß jetzt aber welchen Gedankenfehler ich damals beim Schreiben des Posts hatte. Mit der Synology.me Adresse gab es keine Fehlermeldung bei vaultwarden.Dann kannst du das doch so einrichten, dass du keine Zertifikatsmeldungen mehr erhältst

Ich hatte Anfang Januar die Fehlermeldung beim Mailserver, nachdem sich das Zertifikat erneuert hat. Den Mailserver nutze ich lediglich als Archiv und greife über die IP mit den Mailprogrammen zu.

Also alles gut, hat alles seine Richtigkeit.

Ja, daran habe ich gerade gefallen gefunden. Wusste den Port für Jellyfin nicht mehr auswendig, also ins DSM, im Docker nachgeschaut. Bei der Gelegenheit gleich nen Reverse Proxy eingerichtet. Zukünftig muss ich mir nur die url merken  jellyfin.example.com ist schon richtig schwer

jellyfin.example.com ist schon richtig schwer

jellyfin.example.com ist schon richtig schwer

jellyfin.example.com ist schon richtig schwer

- Registriert

- 28. Okt. 2020

- Beiträge

- 15.837

- Reaktionspunkte

- 6.057

- Punkte

- 589

Hier noch mal ne kurze Rückmeldung von mir. Der letzte Feinschliff fehlt noch.

-Firewall auf dem Proxmox Host

-Veeam Backup: Habe ich vorerst auf Eis gelegt (hab mich daran entlangehangelt) -> erstmal egal, da AB4B & Proxmox Backup läuft

-Firefox Sync läuft auch noch nicht

Was ich zu schätzen gelernt habe: Den Container Yacht. Da bei mir ja prinzipiell alles via Docker läuft in den VMs, ist Yacht sehr komfortabel, um die Ressourcen-Nutzung der Container anzusehen. Die Synology UI gibt es ja nicht und portainer zeigt keine Auslastung an. Hier mal das "Dashboard":

Was aber nicht stimmt: Der angegebene RAM der Maschine. Die VM hat bei mir 6GB. Ist aber auch egal. Mir geht es eher darum, was die Container nutzen.

EDIT: Ich sehe gerade, dass der Gesamt-RAM nur bei einer VM nicht stimmt. Da muss ich gleich mal auf die Suche gehen.

EDIT2: Liegt wohl am Ballooning und dem minimal zugewiesenem Speicher. Obwohl dies bei allen VMs der Fall war, tritt nur bei einer dieses Phänomen auf. Wenn ich min RAM gleich max RAM in Proxmox setze, tritt das Problem nicht auf. Soll zwar angeblich erst bei 80% RAM-Auslastung des Hosts eine Rolle spielen (beschrieben z.B. hier), aber dem ist nicht so. Auch Linux zeigt dann nicht die vollen 6GB an. Hab jetz erstma min=max gesetzt. Dennoch scheint Ballooning zu greifen. Denn die Summe des zugewiesenen RAMs aller VMs ist deutlich höher als die tatsächliche Auslastung auf dem Host.

@Jim_OS betreibst du auch VMs oder nur LXC? Und wenn du VMs hast, hast du Ähnliches festgestellt?

Letztendlich funktioniert nun nach viel Gefrickel alles so, wie ich es am Anfang wollte!

-Firewall auf dem Proxmox Host

-Veeam Backup: Habe ich vorerst auf Eis gelegt (hab mich daran entlangehangelt) -> erstmal egal, da AB4B & Proxmox Backup läuft

-Firefox Sync läuft auch noch nicht

Was ich zu schätzen gelernt habe: Den Container Yacht. Da bei mir ja prinzipiell alles via Docker läuft in den VMs, ist Yacht sehr komfortabel, um die Ressourcen-Nutzung der Container anzusehen. Die Synology UI gibt es ja nicht und portainer zeigt keine Auslastung an. Hier mal das "Dashboard":

Was aber nicht stimmt: Der angegebene RAM der Maschine. Die VM hat bei mir 6GB. Ist aber auch egal. Mir geht es eher darum, was die Container nutzen.

EDIT: Ich sehe gerade, dass der Gesamt-RAM nur bei einer VM nicht stimmt. Da muss ich gleich mal auf die Suche gehen.

EDIT2: Liegt wohl am Ballooning und dem minimal zugewiesenem Speicher. Obwohl dies bei allen VMs der Fall war, tritt nur bei einer dieses Phänomen auf. Wenn ich min RAM gleich max RAM in Proxmox setze, tritt das Problem nicht auf. Soll zwar angeblich erst bei 80% RAM-Auslastung des Hosts eine Rolle spielen (beschrieben z.B. hier), aber dem ist nicht so. Auch Linux zeigt dann nicht die vollen 6GB an. Hab jetz erstma min=max gesetzt. Dennoch scheint Ballooning zu greifen. Denn die Summe des zugewiesenen RAMs aller VMs ist deutlich höher als die tatsächliche Auslastung auf dem Host.

@Jim_OS betreibst du auch VMs oder nur LXC? Und wenn du VMs hast, hast du Ähnliches festgestellt?

Letztendlich funktioniert nun nach viel Gefrickel alles so, wie ich es am Anfang wollte!

Zuletzt bearbeitet:

- Registriert

- 05. Nov. 2015

- Beiträge

- 5.258

- Reaktionspunkte

- 2.520

- Punkte

- 259

Moin,

ich hatte schon das ein oder andere testweise per LXC unter Proxmox laufen, aber aktuell läuft alles in VM und ohne LXC. Was dann viel wie RAM verbraucht und ob es da ggf. irgendwelche Diskrepanzen gibt, hat mich bisher nicht interessiert. Aber ich nutze/brauche ja auch längst nicht so viele Programme wie Du. Meine aktuell 4 bzw. 5 VM (alle Linux als BS) unter Proxmox reichen mir im Moment und mit den gesamt 40 GB RAM in der Kiste brauchte ich mir um die RAM-Verteilung/Nutzung bisher auch noch nicht wirklich Gedanken machen.

Was das Proxmox Monitoring betrifft habe ich mir auch schon das ein oder andere (CheckMK, Zabbix, Graylog, Grafana) angeschaut, aber ich konnte mich noch nicht für eine Lösung entscheiden. Wobei es mir weniger um das Monitoring von Ressourcen geht, sondern ich möchte auch eine vernünftige, möglichst umfangreiche Auswertung und Darstellung der Logs haben. Also etwas in der Art wie das Protokoll-Center von DSM. Das ist das was mir bei Proxmox fehlt und die Darstellung per Linux CLI-Befehlen reicht mir nicht wirklich.

Wobei es mir weniger um das Monitoring von Ressourcen geht, sondern ich möchte auch eine vernünftige, möglichst umfangreiche Auswertung und Darstellung der Logs haben. Also etwas in der Art wie das Protokoll-Center von DSM. Das ist das was mir bei Proxmox fehlt und die Darstellung per Linux CLI-Befehlen reicht mir nicht wirklich.

Bzgl. Veeam: Das läuft bei mir unter Proxmox, aber es waren ja noch ein paar Kleinigkeiten zusätzlich notwendig. Siehe dazu hier ff. Wenn Du PBS nutzt ist das ja auch ok. Ich wollte einfach nur Image-Sicherungen von dem Proxmox Server selber erstellen und dafür war mir PBS zu umfangreich und aufwendig. Schließlich muss man sich um dessen Pflege dann auch noch kümmern. Veeam ist halt schlank, läuft direkt unter Proxmox Debian und evtl. Updates erfolgen automatisch per Proxmox Update Funktion.

BTW Softwarepflege: Wenn ich mir vorstelle ich müsste mich hier zu Hause um so viele VM und Container Software kümmern wie Du hier genannt und im Einsatz hast, hätte ich glaube ich den ganzen Tag nichts anderes zu tun. Allein bei allen VM und Containern auf dem Laufenden zu bleiben, fast täglich Updates zu installieren und sich im Vorfeld dann zu allen Updates bzgl. Änderungen und evtl. Problemen zu informieren ...... Nein danke, auch wenn es ja Hobby ist und auch Spaß macht, aber im Alter verschieben sich (auch) die Prioritäten.

Allein bei allen VM und Containern auf dem Laufenden zu bleiben, fast täglich Updates zu installieren und sich im Vorfeld dann zu allen Updates bzgl. Änderungen und evtl. Problemen zu informieren ...... Nein danke, auch wenn es ja Hobby ist und auch Spaß macht, aber im Alter verschieben sich (auch) die Prioritäten.

VG Jim

ich hatte schon das ein oder andere testweise per LXC unter Proxmox laufen, aber aktuell läuft alles in VM und ohne LXC. Was dann viel wie RAM verbraucht und ob es da ggf. irgendwelche Diskrepanzen gibt, hat mich bisher nicht interessiert. Aber ich nutze/brauche ja auch längst nicht so viele Programme wie Du. Meine aktuell 4 bzw. 5 VM (alle Linux als BS) unter Proxmox reichen mir im Moment und mit den gesamt 40 GB RAM in der Kiste brauchte ich mir um die RAM-Verteilung/Nutzung bisher auch noch nicht wirklich Gedanken machen.

Was das Proxmox Monitoring betrifft habe ich mir auch schon das ein oder andere (CheckMK, Zabbix, Graylog, Grafana) angeschaut, aber ich konnte mich noch nicht für eine Lösung entscheiden.

Wobei es mir weniger um das Monitoring von Ressourcen geht, sondern ich möchte auch eine vernünftige, möglichst umfangreiche Auswertung und Darstellung der Logs haben. Also etwas in der Art wie das Protokoll-Center von DSM. Das ist das was mir bei Proxmox fehlt und die Darstellung per Linux CLI-Befehlen reicht mir nicht wirklich.

Wobei es mir weniger um das Monitoring von Ressourcen geht, sondern ich möchte auch eine vernünftige, möglichst umfangreiche Auswertung und Darstellung der Logs haben. Also etwas in der Art wie das Protokoll-Center von DSM. Das ist das was mir bei Proxmox fehlt und die Darstellung per Linux CLI-Befehlen reicht mir nicht wirklich.Bzgl. Veeam: Das läuft bei mir unter Proxmox, aber es waren ja noch ein paar Kleinigkeiten zusätzlich notwendig. Siehe dazu hier ff. Wenn Du PBS nutzt ist das ja auch ok. Ich wollte einfach nur Image-Sicherungen von dem Proxmox Server selber erstellen und dafür war mir PBS zu umfangreich und aufwendig. Schließlich muss man sich um dessen Pflege dann auch noch kümmern. Veeam ist halt schlank, läuft direkt unter Proxmox Debian und evtl. Updates erfolgen automatisch per Proxmox Update Funktion.

BTW Softwarepflege: Wenn ich mir vorstelle ich müsste mich hier zu Hause um so viele VM und Container Software kümmern wie Du hier genannt und im Einsatz hast, hätte ich glaube ich den ganzen Tag nichts anderes zu tun.

Allein bei allen VM und Containern auf dem Laufenden zu bleiben, fast täglich Updates zu installieren und sich im Vorfeld dann zu allen Updates bzgl. Änderungen und evtl. Problemen zu informieren ...... Nein danke, auch wenn es ja Hobby ist und auch Spaß macht, aber im Alter verschieben sich (auch) die Prioritäten.

Allein bei allen VM und Containern auf dem Laufenden zu bleiben, fast täglich Updates zu installieren und sich im Vorfeld dann zu allen Updates bzgl. Änderungen und evtl. Problemen zu informieren ...... Nein danke, auch wenn es ja Hobby ist und auch Spaß macht, aber im Alter verschieben sich (auch) die Prioritäten.

VG Jim

- Registriert

- 28. Okt. 2020

- Beiträge

- 15.837

- Reaktionspunkte

- 6.057

- Punkte

- 589

Mir ging es dabei eigentlich nicht um Monitoring. Wobei, jetzt wo du es ansprichst, denke ich mir eigentlich schon wieder "will haben" - aber eins nach dem anderen. Mir ging es eher darum, mal eben zu kucken, warum denn der RAM der ein oder anderen VM in Proxmox bei 100% Auslastung steht.Proxmox Monitoring

Das mit Veeam werde ich mir sicherlich irgendwann noch mal anschauen. PBS nutze ich eigentlich schon gar nicht mehr. Ich erstellte Backups direkt aus Proxmox heraus. AB4B zieht sich die Docker-Shares und andere relevante Daten per SMB. Ist nicht soo viel. Wenn der Host abraucht und das Proxmox Backup nicht wiederherstellbar ist, muss ich eigentlich nur eine VM neu aufsetzen, diese klonen, dann die SMB-Daten rücksichern und dann die Container ausrollen. Dürfte in max 2h gemacht sein. Also alles halb so wild.

Ich habe auch nur 4 VMs. Davon ist eine VM nur für Tests reserviert, da läuft nix drauf. Ich habe halt relativ viele Container. Aber außer hin und wieder watchtower drüberlaufen zu lassen, ist da nicht viel Pflege erforderlich. Wenn ich den watchtower laufen lasse, noch mal eben ein update und upgrade der VMs und des Hosts. Dann einmal reboot und feddich. Ist einmal pro Woche ne halbe Stunde (wenn alles gut läuftum so viele VM und Container Software kümmern wie Du

). Und wenn mir dabei ein Container abschmiert, dann zieh ich mir das ältere Image und die Sicherung von gestern und dann passt's wieder.

). Und wenn mir dabei ein Container abschmiert, dann zieh ich mir das ältere Image und die Sicherung von gestern und dann passt's wieder.- Registriert

- 05. Nov. 2015

- Beiträge

- 5.258

- Reaktionspunkte

- 2.520

- Punkte

- 259

Das Problem kenne ich hier bei meinen VM gar nicht, aber im Proxmox Forum tauchen immer mal wieder Beiträge auf wo User von ähnlichen Problemen berichten. Da es mich (bisher) nicht betrifft hat mich das aber nicht weiter interessiert und somit weiß ich nicht warum es dabei dann genau ging.Mir ging es eher darum, mal eben zu kucken, warum denn der RAM der ein oder anderen VM in Proxmox bei 100% Auslastung steht.

VG Jim

- Registriert

- 28. Okt. 2020

- Beiträge

- 15.837

- Reaktionspunkte

- 6.057

- Punkte

- 589

Mir ist das ja auch prinzipiell egal, wenn ich keine Einbußen habe - RAM ist schließlich zum Benutzen da

Einige Container sind halt RAM-hungrig. Wenn aber woanders Bedarf besteht, wird der RAM wieder freigegeben. So ist das zumindest aktuell bei mir.

Einige Container sind halt RAM-hungrig. Wenn aber woanders Bedarf besteht, wird der RAM wieder freigegeben. So ist das zumindest aktuell bei mir.

Kaffeautomat

Wenn du das Forum hilfreich findest oder uns unterstützen möchtest, dann gib uns doch einfach einen Kaffee aus.

Als Dankeschön schalten wir deinen Account werbefrei.