aber wenn ich plang.pl richtig verstehe, nutzt er ja wegen der ganzen „Spielereien“ dafür mehrere VM – um eben eigentlich diesem GAU-Risiko entgegenzutreten…

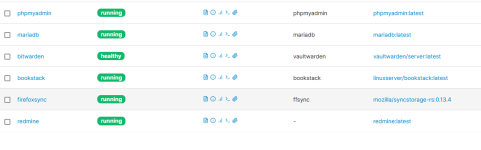

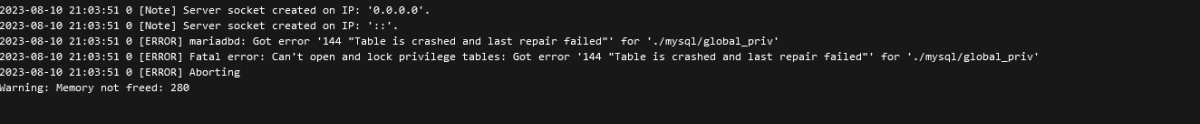

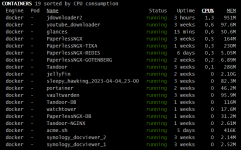

Jepp aber scheinbar eine zentrale MariaDB, in der dann von allen möglichen Anwendungen, ggf. aus unterschiedlichen VM und div. Docker-Anwendungen, etwas gespeichert wird. Wenn die dann abraucht - was ja der Fall zu sein scheint - hat das natürlich Auswirkungen auf alle genutzen Anwendungen.

Im Prinzip ist es auch ja nicht schlecht und oftmals üblich, eine zentrale Datenbank zu nutzen und das ist ja auch "verführerisch",

aber man muss sich dann auch der möglichen Konsequenzen im Klaren sein. Sprich raucht die ab steht ggf. vieles still. Falls man dann diese zentrale Datenbank auch noch für Anwendungen nutzt die man mal ausprobieren will und mit denen man mal etwas "herumspielt", kann das böse ins Auge gehen.

Klar hinterher ist es immer leicht "schlau daher zu reden", was ich ja jetzt auch irgendwie mache,

aber ich sehe halt ein Problem darin wenn man einfach zu viel macht/will. Da verliert man ggf. sehr schnell den Überblick und es treten ggf. Probleme auf die man im Vorfeld gar nicht so wirklich einschätzen kann.

Ich bin mir natürlich sicher das plang.pl das auch alles weiß, dass ihm das auch alles durchaus bewusst ist und das er sich sicherlich vorher überlegt hat was er wie nutzt, was er wie sichert und welche Auswirkungen was haben könnte. Aber manchmal hilft ein "übertreib es aber nicht" vielleicht ja doch,

auch wenn das Kind ggf. schon in den Brunnen gefallen ist.

Das man diese Probleme nicht vorhersehen konnte ist auch klar, aber klar ist auch: Je mehr ich mache, nutze und probieren, umso größer wird das Risiko.

Da er in #178 und #179 ja durchaus unterschiedliche Probleme nennt und beschreibt, wird es wohl ein größeres Problem geben und das auch schon länger. Ob das dann an der Hardware oder der Software liegt muss man sehen.

@plang.pl Ich meine das auch nicht irgendwie böse, oder will "Salz in die Wunde streuen",

aber das mit der zentralen Datenbank, in der dann scheinbar wichtige Daten gespeichert wurden und die dann von unterschiedlichsten Anwendungen genutzt wird, solltest Du Dir ggf. noch einmal überlegen. Ich nutze hier z.B. MariaDB bzw. InfluxDB unter Home Assistant auch nur ausschließlich für HA und käme nicht wirklich auf die Idee diese Datenbank auch noch für div. andere Anwendungen zu nutzen. Einfach weil mir meine HA-Install. sehr wichtig ist und ich nicht wirklich einschätzen kann was andere Anwendungen ggf. für eine Auswirkung auf die Datenbank haben könnten. Ergo nutze ich auch mehrere Datenbanken für unterschiedliche Anwendungen. Aber ok, mein eher kleines "Homelab", mit nur ein paar VM und Docker-Anwendungen, ist sicherlich nicht mit Deinem vergleichbar.

VG Jim

aber man muss sich dann auch der möglichen Konsequenzen im Klaren sein. Sprich raucht die ab steht ggf. vieles still. Falls man dann diese zentrale Datenbank auch noch für Anwendungen nutzt die man mal ausprobieren will und mit denen man mal etwas "herumspielt", kann das böse ins Auge gehen.

aber man muss sich dann auch der möglichen Konsequenzen im Klaren sein. Sprich raucht die ab steht ggf. vieles still. Falls man dann diese zentrale Datenbank auch noch für Anwendungen nutzt die man mal ausprobieren will und mit denen man mal etwas "herumspielt", kann das böse ins Auge gehen. aber ich sehe halt ein Problem darin wenn man einfach zu viel macht/will. Da verliert man ggf. sehr schnell den Überblick und es treten ggf. Probleme auf die man im Vorfeld gar nicht so wirklich einschätzen kann.

aber ich sehe halt ein Problem darin wenn man einfach zu viel macht/will. Da verliert man ggf. sehr schnell den Überblick und es treten ggf. Probleme auf die man im Vorfeld gar nicht so wirklich einschätzen kann. auch wenn das Kind ggf. schon in den Brunnen gefallen ist.

auch wenn das Kind ggf. schon in den Brunnen gefallen ist. für die Datenbank!

für die Datenbank!